« Validation de questionnaire » : différence entre les versions

m (→Introduction) |

mAucun résumé des modifications |

||

| (31 versions intermédiaires par le même utilisateur non affichées) | |||

| Ligne 1 : | Ligne 1 : | ||

{{tutoriel | {{tutoriel | ||

|fait_partie_du_cours=Manuel de recherche en technologie éducative | |fait_partie_du_cours=Manuel de recherche en technologie éducative | ||

|fait_partie_du_module=Statistiques descriptives et échelles | |fait_partie_du_module=Statistiques descriptives et échelles | ||

| | |pas_afficher_sous-page=Non | ||

|statut=brouillon | |statut=brouillon | ||

|dernière_modif=2022/04/16 | |dernière_modif=2022/04/16 | ||

|difficulté= | |difficulté=intermédiaire | ||

|pages_prérequises=Statistiques descriptives, Création d'échelles composées, Principes de base d'analyse statistique, Analyse de régression et corrélations de Pearson, Enquête par sondage et conception de questionnaires | |||

|voir_aussi=Création d'échelles composées, | |||

|all_pages_module=Non | |||

}} | }} | ||

Cet article est un résumé et se base très fortement sur | |||

Cet article est un résumé et se base très fortement sur les contenus du site “[https://psychometrie.espaceweb.usherbrooke.ca/ psychométrie à l’UDS] ” (Le Corff et al., s.d.). | |||

== Introduction == | == Introduction == | ||

| Ligne 20 : | Ligne 24 : | ||

Il est fortement recommandé de mener une étude préliminaire qui permettra de déterminer si le public-cible sera en mesure de comprendre et de répondre aux différentes questions conçue par les chercheur·euse·s. | Il est fortement recommandé de mener une étude préliminaire qui permettra de déterminer si le public-cible sera en mesure de comprendre et de répondre aux différentes questions conçue par les chercheur·euse·s. | ||

== Valider un questionnaire == | == Valider un questionnaire == | ||

La validation d’un questionnaire repose sur trois concepts principaux : | La validation d’un questionnaire (ou plus généralement de n'importe quel instrument psychométrique) repose sur trois concepts principaux : | ||

*La fidélité | *La fidélité | ||

*La validité | *La validité | ||

*La sensibilité et la spécificité | *La sensibilité et la spécificité | ||

=== Fidélité === | === Fidélité === | ||

| Ligne 40 : | Ligne 46 : | ||

*La méthode de stabilité (dans le temps) ou fiabilité test-retest | *La méthode de stabilité (dans le temps) ou fiabilité test-retest | ||

*La méthode de la cohérence interne ou homogénéité des items | *La méthode de la cohérence interne ou homogénéité des items | ||

==== Cohérence interne (homogénéité des items) ==== | ==== Cohérence interne (homogénéité des items) ==== | ||

| Ligne 54 : | Ligne 61 : | ||

La cohérence interne est l’indicateur le plus utilisé pour son côté pratique : en effet, une seule passation permet d’avoir plusieurs indicateurs de fidélité | La cohérence interne est l’indicateur le plus utilisé pour son côté pratique : en effet, une seule passation permet d’avoir plusieurs indicateurs de fidélité | ||

==== Equivalence (formes parallèles) ==== | ==== Equivalence (formes parallèles) ==== | ||

| Ligne 62 : | Ligne 70 : | ||

Cette méthode comporte deux désavantages majeurs : premièrement, la production de deux versions d’un même instrument est coûteuse et exige beaucoup de temps. Deuxièmement, deux formes parallèles ne sont jamais équivalentes à 100 % ; il y a donc un fort risque de surestimation de l’erreur de mesure. | Cette méthode comporte deux désavantages majeurs : premièrement, la production de deux versions d’un même instrument est coûteuse et exige beaucoup de temps. Deuxièmement, deux formes parallèles ne sont jamais équivalentes à 100 % ; il y a donc un fort risque de surestimation de l’erreur de mesure. | ||

==== Stabilité dans le temps (fiabilité test-retest) ==== | ==== Stabilité dans le temps (fiabilité test-retest) ==== | ||

| Ligne 70 : | Ligne 79 : | ||

La méthode test-retest est parfois considéré comme le meilleur indicateur de fidélité à l’heure actuelle. Toutefois, cette méthode présente quelques désavantages auxquels il faut faire attention : un intervalle trop long entre les deux passations peut générer un effet de maturation ; un changement de score lié à l’effet du temps qui passe. A contrario, un intervalle trop court peut impliquer un effet de pratique (la personne se rappelle des réponses qu’elle a donné au premier test). C’est pourquoi, il faut toujours préciser l’intervalle de temps entre les deux passations. | La méthode test-retest est parfois considéré comme le meilleur indicateur de fidélité à l’heure actuelle. Toutefois, cette méthode présente quelques désavantages auxquels il faut faire attention : un intervalle trop long entre les deux passations peut générer un effet de maturation ; un changement de score lié à l’effet du temps qui passe. A contrario, un intervalle trop court peut impliquer un effet de pratique (la personne se rappelle des réponses qu’elle a donné au premier test). C’est pourquoi, il faut toujours préciser l’intervalle de temps entre les deux passations. | ||

==== Interprétation des indices ==== | ==== Interprétation des indices ==== | ||

| Ligne 76 : | Ligne 86 : | ||

En pratique, un score de .7 est considéré comme seuil minimal pour considérer la fidélité de l’instrument comme acceptable. Un score de .8 est jugé comme satisfaisant, et un score de .9 et plus est jugé comme excellent. | En pratique, un score de .7 est considéré comme seuil minimal pour considérer la fidélité de l’instrument comme acceptable. Un score de .8 est jugé comme satisfaisant, et un score de .9 et plus est jugé comme excellent. | ||

=== Validité === | === Validité === | ||

| Ligne 89 : | Ligne 100 : | ||

*La validité de construit | *La validité de construit | ||

*La validité de critère | *La validité de critère | ||

==== Validité de contenu ==== | ==== Validité de contenu ==== | ||

| Ligne 106 : | Ligne 118 : | ||

En dehors des concepts étudiés, il est important de faire attention aux instructions données aux personnes évaluées, modalités de présentation des stimuli contraintes de temps (dans le cas des tests de performance chronométrés par exemple), aux modalités de réponse, et aux critères de cotation des résultats. Finalement, la validité de contenu d’un instrument doit être réévaluée périodiquement (au moins tous les dix ans). | En dehors des concepts étudiés, il est important de faire attention aux instructions données aux personnes évaluées, modalités de présentation des stimuli contraintes de temps (dans le cas des tests de performance chronométrés par exemple), aux modalités de réponse, et aux critères de cotation des résultats. Finalement, la validité de contenu d’un instrument doit être réévaluée périodiquement (au moins tous les dix ans). | ||

==== Validité de construit ==== | ==== Validité de construit ==== | ||

| Ligne 113 : | Ligne 126 : | ||

Il existe trois méthodes d’évaluation de la validité de construit : | Il existe trois méthodes d’évaluation de la validité de construit : | ||

* L’analyse des corrélations avec une autre version de l’instrument | * L’analyse des corrélations avec une autre version de l’instrument | ||

* Les analyses factorielles | |||

* L’analyse des corrélations convergentes et divergentes | * L’analyse des corrélations convergentes et divergentes | ||

L’'''analyse des corrélations avec une autre version de l’instrument''' vise à étudier le lien entre l’instrument dont on souhaite vérifier la validité et une autre version de l’instrument dont la validité a été démontrée. Cette méthode est utilisée dans 3 cas principaux: la mise à jour d'un instrument, la création d'un questionnaire pour un nouveau public, ou le changement de modalité d'administration (p.ex. lorsque l’on passe d’une version papier à une version numérique de l’instrument). Globalement, si le coefficient de corrélation r est plus grand que .8 (idéalement, r > .9), alors on peut estimer que l’instrument mesure les même construits et le même modèle théorique que l’instrument d’origine. Puisqu’il nécessite de s’appuyer sur un questionnaire déjà validé par ailleurs, ce type d’analyse n’est pas applicable pour valider la première version d’un instrument. | L’'''analyse des corrélations avec une autre version de l’instrument''' vise à étudier le lien entre l’instrument dont on souhaite vérifier la validité et une autre version de l’instrument dont la validité a été démontrée. Cette méthode est utilisée dans 3 cas principaux: la mise à jour d'un instrument, la création d'un questionnaire pour un nouveau public, ou le changement de modalité d'administration (p.ex. lorsque l’on passe d’une version papier à une version numérique de l’instrument). Globalement, si le coefficient de corrélation r est plus grand que .8 (idéalement, r > .9), alors on peut estimer que l’instrument mesure les même construits et le même modèle théorique que l’instrument d’origine. Puisqu’il nécessite de s’appuyer sur un questionnaire déjà validé par ailleurs, ce type d’analyse n’est pas applicable pour valider la première version d’un instrument. | ||

La validité de construit peut s’analyser via une '''analyse factorielle'''. L’analyse factorielle vise à regrouper statistiquement les variables d’un questionnaire qui sont associées entre elles (pex: au moyen d’une analyse en composantes principales). Le but de cette analyse est de vérifier si les items d’un instrument se regroupent avec les échelles prévues. Le but est aussi de voir si les construits que l’on vise à mesurer forment des facteurs distincts les uns des autres. Cette méthode permet aussi d’évaluer la validité de contenu d’un instrument. | |||

===== Validité convergente et divergente ===== | |||

L’analyse des '''corrélations convergentes et divergentes''' (qu’on découpe parfois en '''“validité convergente”''' et '''“validité divergente”''') peut se faire soit à l’intérieur de l’instrument, soit par comparaison avec un avec un autre instrument. Dans la cas d’une comparaison avec un autre instrument, alors on peut supposer que si l’instrument qu’on veut valider a une bonne validité de construit, on observera des corrélations élevées entre les construits similaires des deux instruments et des corrélations faibles ou nulles pour les construits différents. L’analyse des corrélations convergentes et divergentes à l’intérieur de l’instrument suppose que si les corrélations observées dans l’instrument sont cohérentes avec les prédictions théoriques, alors c’est une preuve de la validité de construit de l’instrument. Par exemple, une échelle d'extraversion ne devrait pas être corrélée à une échelle de performances en maths. | L’analyse des '''corrélations convergentes et divergentes''' (qu’on découpe parfois en '''“validité convergente”''' et '''“validité divergente”''') peut se faire soit à l’intérieur de l’instrument, soit par comparaison avec un avec un autre instrument. Dans la cas d’une comparaison avec un autre instrument, alors on peut supposer que si l’instrument qu’on veut valider a une bonne validité de construit, on observera des corrélations élevées entre les construits similaires des deux instruments et des corrélations faibles ou nulles pour les construits différents. L’analyse des corrélations convergentes et divergentes à l’intérieur de l’instrument suppose que si les corrélations observées dans l’instrument sont cohérentes avec les prédictions théoriques, alors c’est une preuve de la validité de construit de l’instrument. Par exemple, une échelle d'extraversion ne devrait pas être corrélée à une échelle de performances en maths. | ||

Il peut y avoir plusieurs raisons pour observer un faible niveau de validité de construit : premièrement, l’instrument peut ne pas offrir une bonne mesure des construits proposés par le modèle théorique. Deuxièmement, la théorie sur laquelle s’appuie l’instrument peut ne pas être adéquate (et n’est donc pas confirmée par les données empiriques). Les analyses de validité de construit peuvent donc parfois permettre d’apporter des améliorations au modèle théorique et aux construits mesurés. | Il peut y avoir plusieurs raisons pour observer un faible niveau de validité de construit : premièrement, l’instrument peut ne pas offrir une bonne mesure des construits proposés par le modèle théorique. Deuxièmement, la théorie sur laquelle s’appuie l’instrument peut ne pas être adéquate (et n’est donc pas confirmée par les données empiriques). Les analyses de validité de construit peuvent donc parfois permettre d’apporter des améliorations au modèle théorique et aux construits mesurés. | ||

==== Validité de critère ==== | ==== Validité de critère ==== | ||

| Ligne 132 : | Ligne 149 : | ||

* la validité prédictive | * la validité prédictive | ||

La | ===== Validité concomitante ===== | ||

La validité concomitante, ou "validité de concomitance" évalue l'association des résultats de l’instrument à des données déjà disponibles concernant le critère mesuré ou alors à des données obtenues au même moment que celles de l’instrument (par exemple, la corrélation entre des notes scolaires et le QI à un temps donné). | |||

La | ===== Validité prédictive ===== | ||

La validité prédictive vise à vérifier l’association entre les résultats de l’instrument et un critère futur (qui sera mesuré plus tard). Par exemple, on pourra estimer la corrélation entre un QI en début d’année scolaire, et les notes obtenues par des individus en fin d’année. | |||

| Ligne 147 : | Ligne 166 : | ||

La '''validité incrémentielle''' fait référence à apport supplémentaire d’un instrument psychométrique dans une situation donnée. Par exemple, un instrument permettrait de prendre une mesure plus rapide, ou faire une meilleure sélection entre les participants, ou encore, il pourrait générer des informations supplémentaires. | La '''validité incrémentielle''' fait référence à apport supplémentaire d’un instrument psychométrique dans une situation donnée. Par exemple, un instrument permettrait de prendre une mesure plus rapide, ou faire une meilleure sélection entre les participants, ou encore, il pourrait générer des informations supplémentaires. | ||

La '''validité sociale''' d’un instrument est liée à sa pertinence. Pour vérifier cet élément, il convient de vérifier si l’instrument remplit la fonction pour laquelle il a été créé, ainsi que d’évaluer les effets indésirables liés à son utilisation. | La '''validité sociale''' d’un instrument est liée à sa pertinence. Pour vérifier cet élément, il convient de vérifier si l’instrument remplit la fonction pour laquelle il a été créé, ainsi que d’évaluer les effets indésirables liés à son utilisation. | ||

| Ligne 196 : | Ligne 215 : | ||

L’indice de sensibilité se calcule avec la formule : '''VP / (VP + FN)''' | L’indice de sensibilité se calcule avec la formule : '''VP / (VP + FN)''' | ||

==== Spécificité ==== | ==== Spécificité ==== | ||

| Ligne 208 : | Ligne 228 : | ||

L’indice (de sensibilité ou de spécificité) oscille entre '''0''' (qui correspond à une complète incapacité à détecter correctement la présence ou l’absence de la caractéristique mesurée) à '''1''' (une parfaite capacité de détection ou de discrimination). Dans les articles, ces indices sont exprimés en pourcentages pour faciliter la lecture. | L’indice (de sensibilité ou de spécificité) oscille entre '''0''' (qui correspond à une complète incapacité à détecter correctement la présence ou l’absence de la caractéristique mesurée) à '''1''' (une parfaite capacité de détection ou de discrimination). Dans les articles, ces indices sont exprimés en pourcentages pour faciliter la lecture. | ||

La spécificité et la sensibilité sont des indices qui doivent systématiquement être pris ensemble : en effet, la spécificité n’est pas garante de sensibilité et inversement. | La spécificité et la sensibilité sont des indices qui doivent systématiquement être pris ensemble : en effet, la spécificité n’est pas garante de sensibilité et inversement. | ||

== En résumé == | == En résumé == | ||

On peut résumer les différents types de validité avec ce schéma | |||

[[Fichier:Types de validité.png|800px|vignette|centré|Les différents types de validité (adapté de Bolanirwa, 2015 et Taherdoost, 2016)]] | |||

Taherdoost (2016b) a réuni dans un tableau (traduit ci-dessous) les différents tests de validités importants à réaliser pour valider un questionnaire. | Taherdoost (2016b) a réuni dans un tableau (traduit ci-dessous) les différents tests de validités importants à réaliser pour valider un questionnaire. | ||

| Ligne 222 : | Ligne 241 : | ||

{| class="wikitable" | {| class="wikitable" | ||

|+Résumé des différents tests utilisés pour la validation de questionnaires (Adapté de Taherdoost, 2016b) | |+Résumé des différents tests utilisés pour la validation de questionnaires (Adapté de Taherdoost, 2016b) | ||

!Type de validité | ! colspan="2" |Type de validité | ||

!Définition succinte | !Définition succinte | ||

!Niveau de recommandation | !Niveau de recommandation | ||

!Technique suggérée pour l'évaluation | !Technique suggérée pour l'évaluation | ||

|- | |- | ||

|Validité apparente | | colspan="2" |[[Validation_de_questionnaire#Autres_types_de_validité|Validité apparente]] | ||

|Dans quelle mesure les éléments de l'instrument ressemblent, sur le plan linguistique et analytique, à ce qui est censé être mesuré. | |Dans quelle mesure les éléments de l'instrument ressemblent, sur le plan linguistique et analytique, à ce qui est censé être mesuré. | ||

|Recommandé | |Recommandé | ||

| | | | ||

*Évaluation des items par des experts | |||

|- | |- | ||

|Validité de contenu | | colspan="2" |[[Validation_de_questionnaire#Validité_de_contenu| Validité de contenu]] | ||

|Dans quelle mesure les éléments de l'instrument sont pertinents et représentatifs du construit ciblé | |Dans quelle mesure les éléments de l'instrument sont pertinents et représentatifs du construit ciblé | ||

|Fortement recommandé | |Fortement recommandé | ||

|Revue de la littérature | | | ||

*[[La revue de littérature|Revue de la littérature]] | |||

*Panels d'experts | |||

|- | |- | ||

|Validité divergente | | rowspan="2" |[[Validation_de_questionnaire#Validité_de_construit|Validité de construit]] | ||

|[[Validation_de_questionnaire#Validité_convergente_et_divergente|Validité divergente]] | |||

|Dans quelle mesure les mesures de différents construits divergent ou présentent une corrélation minimale entre elles | |Dans quelle mesure les mesures de différents construits divergent ou présentent une corrélation minimale entre elles | ||

|Obligatoire | |Obligatoire | ||

| | | | ||

Analyses en composantes principales (ACP) | *Multitrait-multimethod (MTMM) matrix | ||

*[[Analyse factorielle et analyse en composantes principales|Analyses en composantes principales (ACP)]] | |||

Analyses factorielles confirmatoires (AFC) | *[[Analyse factorielle et analyse en composantes principales|Analyses factorielles confirmatoires (AFC)]] | ||

|- | |- | ||

|Validité convergente | |[[Validation_de_questionnaire#Validité_convergente_et_divergente|Validité convergente]] | ||

|Dans quelle mesure les différentes mesures du même construit convergent ou sont fortement corrélées entre elles. | |Dans quelle mesure les différentes mesures du même construit convergent ou sont fortement corrélées entre elles. | ||

|Obligatoire | |Obligatoire | ||

|MTMM | | | ||

*MTMM | |||

*[[Analyse factorielle et analyse en composantes principales|ACP]] | |||

*[[Analyse factorielle et analyse en composantes principales|AFC]] | |||

|- | |- | ||

|Validité prédictive | | rowspan="3" |[[Validation_de_questionnaire#Validité_de_critère|Validité de critère]] | ||

|[[Validation_de_questionnaire#Validité_prédictive|Validité prédictive]] | |||

|la mesure dans laquelle une mesure prédit une autre mesure | |la mesure dans laquelle une mesure prédit une autre mesure | ||

|Obligatoire | |Obligatoire | ||

|Régressions | | | ||

*[[Analyse de régression et corrélations de Pearson|Régressions]] | |||

* Analyses factorielles discriminantes (AFD) | |||

|- | |- | ||

|Validité concomitante | |[[Validation_de_questionnaire#Validité_concomitante|Validité concomitante]] | ||

|Mesure dans laquelle une mesure est simultanément liée à une autre mesure | |Mesure dans laquelle une mesure est simultanément liée à une autre mesure à laquelle elle est sensée être liée. | ||

|Obligatoire | |Obligatoire | ||

|Analyse des corrélations | | | ||

*[[Analyse de régression et corrélations de Pearson|Analyse des corrélations]] | |||

|- | |- | ||

|Validité postdictive | |Validité postdictive | ||

|La mesure dans laquelle une mesure est liée aux scores d'une autre | |La mesure dans laquelle une mesure est liée aux scores d'une autre mesure déjà établie dans le passé. | ||

|Obligatoire | |Obligatoire | ||

|Analyse des corrélations | | | ||

*[[Analyse de régression et corrélations de Pearson | Analyse des corrélations]] | |||

|- | |- | ||

|Fiabilité / | | colspan="2" |[[Validation_de_questionnaire#Fidélité |Fiabilité / Cohérence interne]] | ||

Cohérence interne | |||

|Mesure dans laquelle la mesure d'un phénomène fournit un résultat stable et cohérent. | |Mesure dans laquelle la mesure d'un phénomène fournit un résultat stable et cohérent. | ||

|Obligatoire | |Obligatoire | ||

|Alpha de Cronbach | | | ||

* Alpha de Cronbach | |||

* Modèles d'équations structurelles | |||

|} | |} | ||

Il est important qu’un questionnaire soit valide et fiable (Bolarinwa, 2015). Voici les différents cas de figure concernant la validité et fiabilité d’un questionnaire : | |||

* '''Ni fiable, ni valide''' : les méthodes de recherche n’atteignent pas l'objectif de la recherche (non valide) et les tentatives ne sont pas ciblées. | |||

* '''Fiable mais non valide''' : les méthodes de recherche n’atteignent pas l'objectif de la recherche, mais des tentatives répétées donnent presque les mêmes résultats (erronés). | |||

* '''Assez valide, mais pas très fiable''' : les méthodes de recherche correspondent assez bien à l'objectif de l'étude, mais des tentatives répétées donnent des résultats très dispersés (non fiables) | |||

* '''Valide et fiable''' : les méthodes de recherche atteignent leur objectif et des tentatives répétées produisent des résultats similaires | |||

== Bibliographie == | == Bibliographie == | ||

* Bolarinwa, O. A. (2015). Principles and methods of validity and reliability testing of questionnaires used in social and health science researches. ''Nigerian Postgraduate Medical Journal, 22''(4), 195. DOI : | * Bolarinwa, O. A. (2015). Principles and methods of validity and reliability testing of questionnaires used in social and health science researches. ''Nigerian Postgraduate Medical Journal, 22''(4), 195. DOI : https://doi.org/10.4103/1117-1936.173959 | ||

* Reynolds, N., Diamantopoulos, A., & Schlegelmilch, B. (1993). Pre-Testing in Questionnaire Design: A Review of the Literature and Suggestions for Further Research. ''Market Research Society. Journal., 35''(2), 1–11. DOI : | |||

*Le Corff, Y., Yergeau, E., Beaudin, M.-E., & Dorceus S. (s.d.). ''Psychométrie à l'UdeS''. Accès : [https://psychometrie.espaceweb.usherbrooke.ca/ https://psychometrie.espaceweb.usherbrooke.ca/] | |||

* Reynolds, N., Diamantopoulos, A., & Schlegelmilch, B. (1993). Pre-Testing in Questionnaire Design: A Review of the Literature and Suggestions for Further Research. ''Market Research Society. Journal., 35''(2), 1–11. DOI : https://doi.org/10.1177/147078539303500202 | |||

* Singh, A. S. (2017). Common procedures for development, validity and reliability of a questionnaire. ''International Journal of Economics, Commerce and Management, 5''(5), 790-801. | * Singh, A. S. (2017). Common procedures for development, validity and reliability of a questionnaire. ''International Journal of Economics, Commerce and Management, 5''(5), 790-801. | ||

* Taherdoost, H. (2016a). Validity and Reliability of the Research Instrument; How to Test the Validation of a Questionnaire/Survey in a Research. ''International Journal of Academic Research in Management (IJARM), 5''(3) 28-36. | * Taherdoost, H. (2016a). Validity and Reliability of the Research Instrument; How to Test the Validation of a Questionnaire/Survey in a Research. ''International Journal of Academic Research in Management (IJARM), 5''(3) 28-36. | ||

* Taherdoost, H. (2016b). How to design and create an effective survey/questionnaire; A step by step guide. ''International Journal of Academic Research in Management (IJARM), 5''(4), 37-41. | * Taherdoost, H. (2016b). How to design and create an effective survey/questionnaire; A step by step guide. ''International Journal of Academic Research in Management (IJARM), 5''(4), 37-41. | ||

Dernière version du 24 avril 2022 à 13:35

| Manuel de recherche en technologie éducative | |

|---|---|

| Module: Statistiques descriptives et échelles | |

| ⚐ brouillon | ☸ intermédiaire |

| ⚒ 2022/04/24 | ⚒⚒ 2022/04/16 |

| Prérequis | |

| Voir aussi | |

Cet article est un résumé et se base très fortement sur les contenus du site “psychométrie à l’UDS ” (Le Corff et al., s.d.).

Introduction

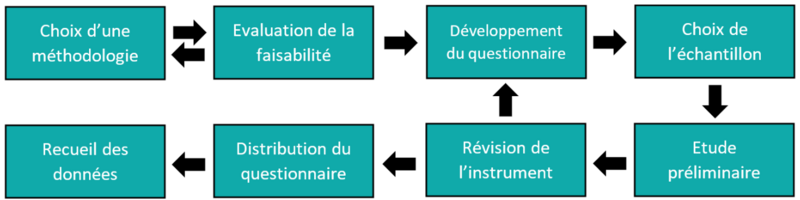

L’intérêt d’un questionnaire est de pouvoir facilement le distribuer (en particulier lorsqu’ils sont auto-administrés par internet) et de pouvoir faire des analyses statistiques sur les réponses produites. Ainsi, on peut en déduire des informations précises, et ces derniers peuvent constituer des informations qui peuvent être utilisées dans des recherches tant qualitatives que quantitatives (Taherdoost, 2016a).

D’après Taherdoost (2016a), il est essentiel de tester un questionnaire au préalable avec un groupe limité d’individus similaires à l’échantillon envisagé. L’idée est de pouvoir mettre en évidence d’éventuelles ambiguïtés, ainsi que des erreurs potentielles.

Il est fortement recommandé de mener une étude préliminaire qui permettra de déterminer si le public-cible sera en mesure de comprendre et de répondre aux différentes questions conçue par les chercheur·euse·s.

Valider un questionnaire

La validation d’un questionnaire (ou plus généralement de n'importe quel instrument psychométrique) repose sur trois concepts principaux :

- La fidélité

- La validité

- La sensibilité et la spécificité

Fidélité

Introduction

La fidélité d’un instrument psychométrique correspond au degré de précision et de constance de ses scores. Un instrument précis aura des scores proches de la caractéristique réelle mesurée. La constance d’un instrument fait référence à la stabilité des scores obtenus par un·e même participant·e avec un même instrument.

La fidélité est aussi proche du concept d’erreur de mesure. Plus un instrument est fidèle, moins il contient d’erreur de mesure ; ainsi, plus le score est proche de la vraie caractéristique de la personne. Prenons l’exemple d’un instrument mesurant l’intelligence humaine dont le score de fidélité serait maximal. Le score d’un individu sur cet instrument représenterait donc exactement son niveau d’intelligence.

Il existe trois méthodes principales d’estimation de la fidélité d’un instrument :

- La méthode d’équivalence ou méthode des formes parallèles

- La méthode de stabilité (dans le temps) ou fiabilité test-retest

- La méthode de la cohérence interne ou homogénéité des items

Cohérence interne (homogénéité des items)

La méthode de la cohérence interne (ou homogénéité des items) réfléchit si les items qui constituent un instrument mesurent effectivement les mêmes concepts (ou non). En d’autre termes, la cohérence interne vérifie la cohésion des items qui composent l'instrument (ou chacune de ses échelles) en vérifiant la corrélation entre les scores au sein de l’instrument même.

Il existe deux méthodes pour évaluer l’homogénéité des items d’un instrument :

- la méthode de bissection

- la méthode des covariances

La méthode de bissection consiste en la comparaison des deux moitiés d’un même instrument psychométrique comme s’il s’agissait de deux versions parallèles. Elle équivaut donc à la méthode d’équivalence (ou méthode des formes parallèles) mais sur la moitié des items de la version originale. En effet, au lieu de créer deux versions d’un même questionnaire, on évalue la corrélation entre les deux moitiés du même instrument. Pour générer les deux moitiés d’instruments, il existe deux méthodes: la méthode première/deuxième moitié (très peu utilisée car génère trop de biais) et la méthode pairs/impairs (plus utilisée, elle consiste en l’évaluation de la corrélation des items pairs avec les items impairs). Un grand désavantage de la méthode de bissection est que l’on risque de sous-estimer la fiabilité de l’instrument : étant donné que la fidélité est influencée par le nombre d’items (i.e. plus il y a d’items, plus il y aura de différences individuelles observées, plus l’instrument sera considéré comme fidèle), en sciendent en deux l’instrument, la fidélité va être fortement impactée.

La méthode des covariances repose sur une idée principale : des items homogènes (i.e. mesurant un même concept) devraient avoir un score de covariance élevée ; ils devraient donc avoir une forte corrélation. La méthode des covariance estime la fidélité du score composite à partir de la fidélité de ses parties (les items) et qu’elle mesure la cohérence entre les performances à tous les items d’un instrument. Cet indice se mesure au moyen de l’alpha de Cronbach. Cette méthode est largement utilisée, mais présente quelques désavantages : premièrement, cette méthode suppose que chaque item d’un instrument psychométrique est parallèle aux autres (i.e. ils ont une même variance et un même niveau de difficulté), or c’est rarement le cas ; on risque donc de sous-estimer la fidélité du score total. Deuxièmement, il peut arriver qu’un instrument psychométrique mesure des contenus hétérogènes, c’est-à-dire des items dont la corrélation, entre eux, ne serait pas optimale ; cet indice est donc contre-indiqué dans ce genre de cas de figure.

La cohérence interne est l’indicateur le plus utilisé pour son côté pratique : en effet, une seule passation permet d’avoir plusieurs indicateurs de fidélité

Equivalence (formes parallèles)

Aussi appelée méthode des formes parallèles, la méthode d’équivalence repose sur l’administration de deux versions d’un même instrument. L’idée est qu’un même individu devrait obtenir un même score à chaque version. Ainsi, les scores diffèreront en fonction de l’erreur de mesure de l’instrument.

L’équivalence se mesure avec un coefficient de corrélation : plus les deux versions du questionnaire sont liées, moins l’instrument comporte d’erreurs de mesure.

Cette méthode comporte deux désavantages majeurs : premièrement, la production de deux versions d’un même instrument est coûteuse et exige beaucoup de temps. Deuxièmement, deux formes parallèles ne sont jamais équivalentes à 100 % ; il y a donc un fort risque de surestimation de l’erreur de mesure.

Stabilité dans le temps (fiabilité test-retest)

La méthode de stabilité (ou fiabilité test-retest) est liée à l’idée qu’un instrument fidèle produit les mêmes résultats chez une même personne à deux moments. La variance entre les scores du premier test (test) et du second test (retest) représente la variance du score vrai, alors que la proportion de variance non partagée entre les deux sera attribuable à l’erreur de mesure. L’idée est qu’un instrument fidèle devrait produire les mêmes résultats chez une même personne à deux moments différents.

L’indice de stabilité se mesure avec le coefficient de corrélation entre la première et la seconde passation du test.

La méthode test-retest est parfois considéré comme le meilleur indicateur de fidélité à l’heure actuelle. Toutefois, cette méthode présente quelques désavantages auxquels il faut faire attention : un intervalle trop long entre les deux passations peut générer un effet de maturation ; un changement de score lié à l’effet du temps qui passe. A contrario, un intervalle trop court peut impliquer un effet de pratique (la personne se rappelle des réponses qu’elle a donné au premier test). C’est pourquoi, il faut toujours préciser l’intervalle de temps entre les deux passations.

Interprétation des indices

Les différents indices de fidélité présentés s’interprêtent de manière similaire : plus l’indice (alpha ou coefficient de corrélation) est proche de 1, plus l’instrument est fidèle, plus il est proche de la réalité. Par exemple, un score de r = .95 suppose que 95% de la variance du score observé est attribuable au score vrai de la personne évaluée, et 5 % de la variance du score est attribuable à l’erreur de mesure de l’instrument.

En pratique, un score de .7 est considéré comme seuil minimal pour considérer la fidélité de l’instrument comme acceptable. Un score de .8 est jugé comme satisfaisant, et un score de .9 et plus est jugé comme excellent.

Validité

Introduction

La validité est le plus important et fondamental du processus de construction et de validation d’un instrument psychométrique. La validité détermine la capacité de l'instrument à mesurer ce qu’il a été conçu pour mesurer. Elle permet d’établir les conditions dans lesquelles ses résultats peuvent être correctement utilisés.

La validité n’est pas un concept “absolu” : elle est toujours liée à un objectif ou un contexte ; elle est aussi liée au temps et au lieu dans lequel l’instrument est construit et validé.

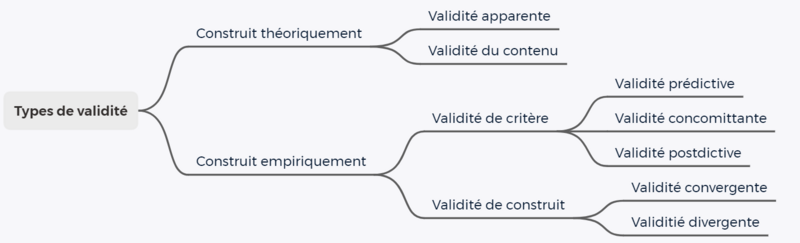

La validité peut se décomposer en trois éléments principaux :

- La validité de contenu

- La validité de construit

- La validité de critère

Validité de contenu

La validité de contenu estime dans quelle mesure les items d’un instrument sont représentatifs des concepts que l’on veut mesurer et des facettes qui les constituent.

Pour avoir une bonne validité de contenu, les items (ou les épreuves) doivent couvrir tous les aspects principaux du construit mesuré. Aussi, les items doivent couvrir ces différents aspects de manière proportionnelle. Finalement, l’instrument ne doit pas contenir d’épreuves ou d’items non-pertinents.

Richard et Kubany (2005) ont énoncé 7 règles pour déterminer la validité de contenu d’un instrument psychométrique :

- Définir le domaine et les facettes du construit mesuré et valider cette définition.

- Utiliser un échantillon d’experts et de membres de la population cible pour créer les items

- Soumettre tous les aspects de l’instrument à une validation de contenu (y compris la forme).

- Consulter plusieurs experts pour valider le contenu et quantifier leurs jugements à l’aide d'échelles

- Examiner la représentation proportionnelle des items relativement aux différentes facettes du construit

- Présenter les résultats de la validation de contenu lors de la publication de tout nouvel instrument

- Prendre en compte toutes les analyses psychométriques ultérieures pour affiner la validation du contenu

En dehors des concepts étudiés, il est important de faire attention aux instructions données aux personnes évaluées, modalités de présentation des stimuli contraintes de temps (dans le cas des tests de performance chronométrés par exemple), aux modalités de réponse, et aux critères de cotation des résultats. Finalement, la validité de contenu d’un instrument doit être réévaluée périodiquement (au moins tous les dix ans).

Validité de construit

Aussi appelée validité de construction, validité théorique ou validité conceptuelle, son but est de s’assurer que l’instrument mesure vraiment les construits qu’il mesure. La validité de construit vérifie aussi que l’instrument offre une mesure adéquate du modèle théorique sur lequel il s’appuie.

Il existe trois méthodes d’évaluation de la validité de construit :

- L’analyse des corrélations avec une autre version de l’instrument

- Les analyses factorielles

- L’analyse des corrélations convergentes et divergentes

L’analyse des corrélations avec une autre version de l’instrument vise à étudier le lien entre l’instrument dont on souhaite vérifier la validité et une autre version de l’instrument dont la validité a été démontrée. Cette méthode est utilisée dans 3 cas principaux: la mise à jour d'un instrument, la création d'un questionnaire pour un nouveau public, ou le changement de modalité d'administration (p.ex. lorsque l’on passe d’une version papier à une version numérique de l’instrument). Globalement, si le coefficient de corrélation r est plus grand que .8 (idéalement, r > .9), alors on peut estimer que l’instrument mesure les même construits et le même modèle théorique que l’instrument d’origine. Puisqu’il nécessite de s’appuyer sur un questionnaire déjà validé par ailleurs, ce type d’analyse n’est pas applicable pour valider la première version d’un instrument.

La validité de construit peut s’analyser via une analyse factorielle. L’analyse factorielle vise à regrouper statistiquement les variables d’un questionnaire qui sont associées entre elles (pex: au moyen d’une analyse en composantes principales). Le but de cette analyse est de vérifier si les items d’un instrument se regroupent avec les échelles prévues. Le but est aussi de voir si les construits que l’on vise à mesurer forment des facteurs distincts les uns des autres. Cette méthode permet aussi d’évaluer la validité de contenu d’un instrument.

Validité convergente et divergente

L’analyse des corrélations convergentes et divergentes (qu’on découpe parfois en “validité convergente” et “validité divergente”) peut se faire soit à l’intérieur de l’instrument, soit par comparaison avec un avec un autre instrument. Dans la cas d’une comparaison avec un autre instrument, alors on peut supposer que si l’instrument qu’on veut valider a une bonne validité de construit, on observera des corrélations élevées entre les construits similaires des deux instruments et des corrélations faibles ou nulles pour les construits différents. L’analyse des corrélations convergentes et divergentes à l’intérieur de l’instrument suppose que si les corrélations observées dans l’instrument sont cohérentes avec les prédictions théoriques, alors c’est une preuve de la validité de construit de l’instrument. Par exemple, une échelle d'extraversion ne devrait pas être corrélée à une échelle de performances en maths.

Il peut y avoir plusieurs raisons pour observer un faible niveau de validité de construit : premièrement, l’instrument peut ne pas offrir une bonne mesure des construits proposés par le modèle théorique. Deuxièmement, la théorie sur laquelle s’appuie l’instrument peut ne pas être adéquate (et n’est donc pas confirmée par les données empiriques). Les analyses de validité de construit peuvent donc parfois permettre d’apporter des améliorations au modèle théorique et aux construits mesurés.

Validité de critère

Aussi appelée, validité critériée, ou encore validité pragmatique, la validité de critère vise vérifier la capacité d’un instrument à distinguer les individus entre eux. L’idée est donc de déterminer à quel point ses résultats sont associés à une variable indépendante auxquels ils devraient normalement être associés. En d’autres termes, la validité de critère vérifie donc le degré d’association entre l’instrument et une variable que l’on souhaite prédire ou expliquer avec celui-ci (par exemple, un test d'intelligence pourrait prédire la réussite scolaire).

La validité de critère se découpe en deux types de validités :

- la validité concomitante

- la validité prédictive

Validité concomitante

La validité concomitante, ou "validité de concomitance" évalue l'association des résultats de l’instrument à des données déjà disponibles concernant le critère mesuré ou alors à des données obtenues au même moment que celles de l’instrument (par exemple, la corrélation entre des notes scolaires et le QI à un temps donné).

Validité prédictive

La validité prédictive vise à vérifier l’association entre les résultats de l’instrument et un critère futur (qui sera mesuré plus tard). Par exemple, on pourra estimer la corrélation entre un QI en début d’année scolaire, et les notes obtenues par des individus en fin d’année.

Autres types de validité

Au-delà des critères de validité présentés ci-dessus, on peut encore dénombrer d’autres types de validité.

La validité apparente se définit comme le degré de croyance quant à la valeur de l’instrument utilisé dans un certain contexte et dans un certain but. C’est une évaluation subjective, et elle ne constitue pas une preuve psychométrique en soi.

La validité différentielle suppose que les conditions de certaines personnes peut avoir un impact sur la validité. Par exemple, un test d’intelligence n’a pas la même validité sur une population d’enfants que d'adultes. Il faut donc évaluer la validité (de contenu, de construit et de critère) en fonction des différents sous-groupes auxquels on souhaite appliquer l’instrument.

La validité incrémentielle fait référence à apport supplémentaire d’un instrument psychométrique dans une situation donnée. Par exemple, un instrument permettrait de prendre une mesure plus rapide, ou faire une meilleure sélection entre les participants, ou encore, il pourrait générer des informations supplémentaires.

La validité sociale d’un instrument est liée à sa pertinence. Pour vérifier cet élément, il convient de vérifier si l’instrument remplit la fonction pour laquelle il a été créé, ainsi que d’évaluer les effets indésirables liés à son utilisation.

Sensibilité et spécificité

La sensibilité et la spécificité sont deux concepts liés à la validation d’un instrument dont le but est de repérer une caractéristique dichotomique (comme malade/sain par exemple). Ces deux critères sont parfois considérés comme des indices de validité. Ces deux éléments peuvent être calculés dans le cadre de l’étude de la validité de critère d’un instrument.

Les deux indices sont liés aux notions de de

- vrais positifs (VP) : cas repérés par l’instrument comme ayant la caractéristique ayant réellement la caractéristique

- faux positifs (FP) : cas repérés par l’instrument comme ayant la caractéristique mais n’ayant pas la caractéristique en réalité

- vrais négatifs (VN) : cas repérés par l’instrument comme n’ayant pas la caractéristique qui ne possèdent effectivement pas la caractéristique

- faux négatifs (FN) : cas repérés par l’instrument comme n’ayant pas la caractéristique alors qu’ils possèdent la caractéristique

Ces différents cas peuvent être résumés dans avec la matrice suivante :

| Statut réel | ||||

|---|---|---|---|---|

| Cas | Non cas | Total | ||

| Résultat | Positif | VP

(vrai positifs) |

FP

(faux positifs) |

VP+FP |

| Négatif | FN

(faux négatifs) |

VN

(faux négatifs) |

FN + VN | |

| Total | VP + FN | FP + VN | ||

Sensibilité

La sensibilité (ou capacité de détection) correspond à la capacité d’un instrument à détecter les cas qui possèdent réellement la caractéristique mesurée ; c’est la probabilité qu’un « cas » soit identifié correctement par l’instrument. On cherche donc à repérer les “vrais positifs” et éviter les “faux négatifs”.

L’indice de sensibilité se calcule avec la formule : VP / (VP + FN)

Spécificité

La spécificité (ou capacité de discrimination) correspond à la capacité de l’instrument à détecter les cas qui n'ont pas la caractéristique. On cherche donc à identifier les vrais négatifs et éviter les faux positifs.

L’indice de spécificité se calcule avec la formule : VN / (VN + FP)

Interprétation

L’indice (de sensibilité ou de spécificité) oscille entre 0 (qui correspond à une complète incapacité à détecter correctement la présence ou l’absence de la caractéristique mesurée) à 1 (une parfaite capacité de détection ou de discrimination). Dans les articles, ces indices sont exprimés en pourcentages pour faciliter la lecture.

La spécificité et la sensibilité sont des indices qui doivent systématiquement être pris ensemble : en effet, la spécificité n’est pas garante de sensibilité et inversement.

En résumé

On peut résumer les différents types de validité avec ce schéma

Taherdoost (2016b) a réuni dans un tableau (traduit ci-dessous) les différents tests de validités importants à réaliser pour valider un questionnaire.

| Type de validité | Définition succinte | Niveau de recommandation | Technique suggérée pour l'évaluation | |

|---|---|---|---|---|

| Validité apparente | Dans quelle mesure les éléments de l'instrument ressemblent, sur le plan linguistique et analytique, à ce qui est censé être mesuré. | Recommandé |

| |

| Validité de contenu | Dans quelle mesure les éléments de l'instrument sont pertinents et représentatifs du construit ciblé | Fortement recommandé |

| |

| Validité de construit | Validité divergente | Dans quelle mesure les mesures de différents construits divergent ou présentent une corrélation minimale entre elles | Obligatoire |

|

| Validité convergente | Dans quelle mesure les différentes mesures du même construit convergent ou sont fortement corrélées entre elles. | Obligatoire | ||

| Validité de critère | Validité prédictive | la mesure dans laquelle une mesure prédit une autre mesure | Obligatoire |

|

| Validité concomitante | Mesure dans laquelle une mesure est simultanément liée à une autre mesure à laquelle elle est sensée être liée. | Obligatoire | ||

| Validité postdictive | La mesure dans laquelle une mesure est liée aux scores d'une autre mesure déjà établie dans le passé. | Obligatoire | ||

| Fiabilité / Cohérence interne | Mesure dans laquelle la mesure d'un phénomène fournit un résultat stable et cohérent. | Obligatoire |

| |

Il est important qu’un questionnaire soit valide et fiable (Bolarinwa, 2015). Voici les différents cas de figure concernant la validité et fiabilité d’un questionnaire :

- Ni fiable, ni valide : les méthodes de recherche n’atteignent pas l'objectif de la recherche (non valide) et les tentatives ne sont pas ciblées.

- Fiable mais non valide : les méthodes de recherche n’atteignent pas l'objectif de la recherche, mais des tentatives répétées donnent presque les mêmes résultats (erronés).

- Assez valide, mais pas très fiable : les méthodes de recherche correspondent assez bien à l'objectif de l'étude, mais des tentatives répétées donnent des résultats très dispersés (non fiables)

- Valide et fiable : les méthodes de recherche atteignent leur objectif et des tentatives répétées produisent des résultats similaires

Bibliographie

- Bolarinwa, O. A. (2015). Principles and methods of validity and reliability testing of questionnaires used in social and health science researches. Nigerian Postgraduate Medical Journal, 22(4), 195. DOI : https://doi.org/10.4103/1117-1936.173959

- Le Corff, Y., Yergeau, E., Beaudin, M.-E., & Dorceus S. (s.d.). Psychométrie à l'UdeS. Accès : https://psychometrie.espaceweb.usherbrooke.ca/

- Reynolds, N., Diamantopoulos, A., & Schlegelmilch, B. (1993). Pre-Testing in Questionnaire Design: A Review of the Literature and Suggestions for Further Research. Market Research Society. Journal., 35(2), 1–11. DOI : https://doi.org/10.1177/147078539303500202

- Singh, A. S. (2017). Common procedures for development, validity and reliability of a questionnaire. International Journal of Economics, Commerce and Management, 5(5), 790-801.

- Taherdoost, H. (2016a). Validity and Reliability of the Research Instrument; How to Test the Validation of a Questionnaire/Survey in a Research. International Journal of Academic Research in Management (IJARM), 5(3) 28-36.

- Taherdoost, H. (2016b). How to design and create an effective survey/questionnaire; A step by step guide. International Journal of Academic Research in Management (IJARM), 5(4), 37-41.