Designs de recherche orientés recherche design

| Manuel de recherche en technologie éducative | |

|---|---|

| ◀▬▬▶ | |

| ⚐ à améliorer | ☸ débutant |

| ⚒ 2015/04/08 | ⚒⚒ 2015/03/27 |

Introduction

Dans ce chapitre, nous présenterons la perspective de la science design. La technologie éducative en tant que science design utilise principalement des approches qualitatives orientées formulation de théorie, mais peut aussi reposer sur des approches quantitatives, telles que les expériences ou les enquêtes par sondage. Ce qui singularise la recherche design réside justement dans l’importance du design, i.e. les règles ou recommandations de design et les artéfacts crées durant ce type de recherche.

Objectifs d'apprentissage

- Comprendre les objectifs de la recherche design

- Comprendre la nature du processus et le principe du design traditionnel vs le design participatif agile

- Etre capable de reconnaître un langage de design

- Comprendre les objectifs de la Recherche Design en Education (RDE) dans le domaine de de la technologie éducative

- Etre capable de conduire une étude d'évaluation simple

Les sciences design existent depuis longtemps, notamment en architecture et en ingénierie. Les chercheurs en ingénierie pédagogique et en technologie éducative ont explicitement manifesté le besoin d’une recherche orientée design plus récemment (dans les années 1990). Le dénommé mouvement pour la recherche design en éducation en est un bon exemple: The Design Based Research Collective, http://www.designbasedresearch.org/ . Le mouvement est actif, par exemple avec la: Design Based Research Conference 2013, http://dbrxroads.coe.uga.edu/ .

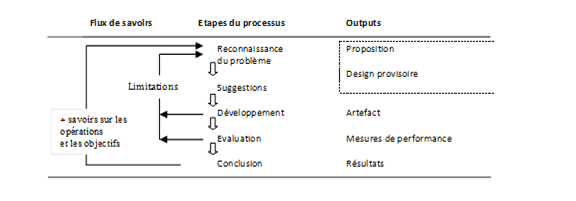

Les ingrédients ou les étapes types d’une recherche design sont résumés dans la Figure 43: Méthodologie générale d'une recherche affiliée à la science du design (Jrvinen, 2007)' .

«Un cycle débute par l’identification d’un problème, par un praticien ou un chercheur. En se basant sur la théorie à même de pouvoir répondre à la problématique, le chercheur formule des suggestions et une proposition qui seront ensuite développées dans un artefact. Celui-ci sera évalué, notamment à l’aide de mesures de performances. Les étapes de développement / évaluation / suggestions sont reproduites autant de fois que nécessaires et la conclusion met un point final à un cycle.

Selon l’ampleur des études, le nombre d’itérations varie d’une recherche à l’autre. Notons qu’indépendamment de la taille de l’étude et du nombre d’itérations, un invariant demeure: l’objectif de ce processus itératif est toujours double. En partant du savoir scientifique et de l’état de l’art, l’objectif d’une recherche de type science du design vise toujours à développer une intervention au niveau de la pratique et à créer et documenter du savoir réutilisable, ancré dans la théorie sinon constitutif de nouveaux éléments théoriques » (Class & Schneider, 2013).

Le processus de design

La science design moderne est influencée par plusieurs domaines, e.g. l'architecture ou l'ingénierie logicielle. Pertti Jrvinen (2004: 103) a formulé deux possibilités principales pour son processus (Figure 48). Vous devez choisir entre une approche plutôt descendante ("top-down", aussi appelée modèle en chute d'eau) et une approche plutôt participative et "agile".

Dans la recherche en technologie éducative, on utilise le plus souvent une sorte de méthode de design agile et itérative pour développer des logiciels et des environnements innovants. D'autre part, la théorie traditionnelle d’ingénierie pédagogique utilise plutôt une approche hiérarchique, apparentée au "modèle en chute d'eau". Présentons maintenant quelques "méthodes agiles".

Le modèle de design participatif centré sur l'utilisateur

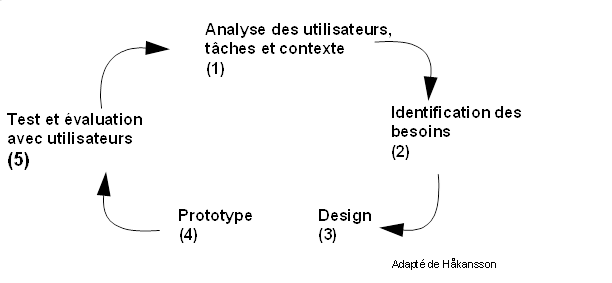

Le design centré sur l'utilisateur(Figure 49):

- implique les utilisateurs dans la conception de l’artéfact de façon à ce qu'ils puissent l'influencer;

- intègre des connaissances et des expertises issues d'autres domaines et non pas seulement des TIC;

- est hautement itératif afin que les tests permettent d'assurer que le design réponde aux exigences des utilisateurs.

Le design participatif ne revient pas seulement à analyser les besoins des utilisateurs (demander ce qu'ils veulent et étudier les besoins), mais il signifie que les utilisateurs 'participeront activement aux différents cycles de conception'.

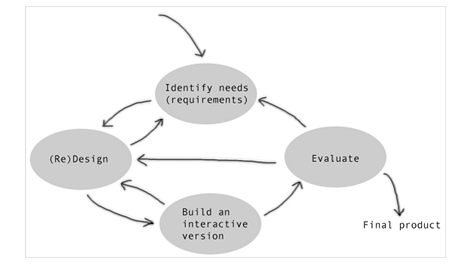

Un modèle similaire développé par Preece, Rogers et Sharp (2002) est montré dans la Figure 50 dessinée par Hkansson. Cette figure montre que le "design" implique de construire des artéfacts interactifs. Le fait d'utiliser et de tester ces artéfacts mènera à reformuler les besoins (exigences). Ces deux actions mèneront à une nouvelle conception ("redesign"). Lors d'étapes ultérieures, l'artefact montré en exemple devra être évalué, ce qui peut, encore une fois, mener à une nouvelle conception.

Techniques d'analyse d’utilisateurs

La plupart des techniques d'analyse d’utilisateurs repose sur des méthodes d'analyse de données qualitatives. Selon Hkansson, les techniques d'analyse d’utilisateurs les plus répandues sont les suivantes:

1. Les questionnaires: si le nombre d'utilisateurs est élevé et si vous savez précisément quelles questions poser (e.g. identifier les profils d'utilisateurs, tester les hypothèses tirées d'études approfondies, etc.)

2. Entretiens semi-structurés: pour étudier de nouvelles questions et pour laisser les participants développer leurs arguments (causalités subjectives)

3. Focus groups: entretiens de groupe pour récolter des points de vue multiples

4. Observations/Ethnographie: observer comment le travail se déroule dans son contexte naturel (observer le workflow lié aux tâches, les interactions) et comprendre le contexte (autres interactions, conditions)

5. Méthode des scénarios (descriptions narratives informelles) pour comprendre les flux d'activité et d’interaction, les processus cognitifs et de raisonnement. Les utilisateurs sont placés devant des scénarios construits et doivent décrire comment les différents acteurs impliqués vont interagir pour accomplir leurs tâches respectives.

6. Investigations culturelles (cultural probes), une approche alternative pour comprendre les utilisateurs et leurs besoins, développée par Gaver (1999)

Définition des exigences

Avant de construire un artéfact, vous devrez définir des exigences. Il en existe différents types dont nous dressons une courte liste:

- Exigences fonctionnelles

- Exigences environnementales

- Exigences physiques, sociales, organisationelles, techniques

- Exigences des utilisateurs

- Exigences d'utilisabilité

Remarque: il est fort probable que la liste initiale d'exigences change durant le processus de design. Souvent, lorsque les utilisateurs sont exposés au premier prototype réel, ils viennent à exprimer une série de nouveaux besoins.

Construire des prototypes

Les prototypes peuvent être des produits très divers. "Depuis les storyboards sur papier jusqu'à des logiciels complexes, ils peuvent être : des modèles papier en 3D, des maquettes en carton, des captures d'écrans reliées par hyperliens, des vidéo-simulations d'une tâche, des versions en plastique ou en métal du produit final" (Hkansson).

La nature des prototypes diffère selon les étapes et l'évolution du processus de design. Les prototypes peuvent être:

- Une aide utile pour discuter les idées en cours (e.g. vous avez seulement besoin d'un storyboard dans ce cas);

- Une aide utile pour clarifier des exigences vagues (e.g. vous avez seulement besoin d'une maquette d’interface utilisateur);

- Une aide utile pour le test avec des utilisateurs réels (e.g. vous avez seulement besoin d'une fonctionnalité partielle de l’implémentation).

La recherche design en éducation (RDE)

La recherche design en éducation (appelée, en anglais, Educational Design Research, Design Based Research ou Design Experiment) est une approche qui a été développée spécifiquement par des experts de la technologie éducative.

Selon Collins et al (2004: 15), "le terme expérience de design a été introduit en 1992, dans des articles d'Ann Brown (1992) et d'Allan Collins (1992). Des expériences de design ont été développées pour conduire de la recherche formative pour tester et affiner des designs éducatifs basés sur des principes issus de recherches antérieures." Selon Reeves (2000:8), les expériences de design de Brown et Collins se caractérisent par le fait de:

- traiter des problèmes complexes dans des contextes réels en collaboration avec des professionnels;

- intégrer des principes de design reconnus et/ou hypothétiques à des affordances technologiques pour rendre plausibles les solutions apportées à ces problèmes complexes;

- conduire une investigation rigoureuse et réflexive pour tester et affiner des environnements d'apprentissage novateurs ainsi que pour définir de nouveaux principes de design.

Selon Collins et al (2004: 16), la recherche design a été développée pour traiter différentes questions centrales dans le domaine de la recherche sur l'apprentissage, y compris les suivantes:

- Le besoin de traiter des questions théoriques sur la nature de l'apprentissage en contexte réel;

- Le besoin d'approches pour étudier l'apprentissage en situation réelle plutôt qu’en situation de laboratoire;

- Le besoin d'aller au-delà de mesures à court-terme de l'apprentissage;

- Le besoin d’extraire des résultats de recherche d’évaluations formatives.

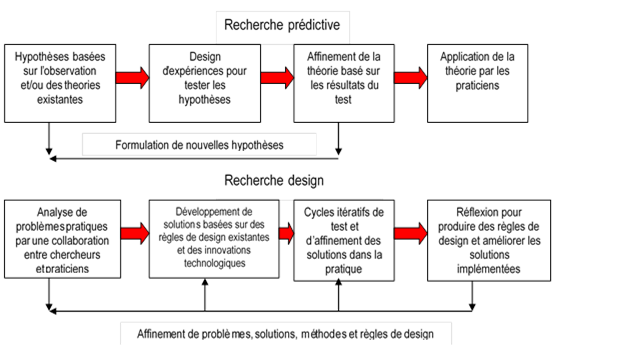

Reeves (2000:9; 2006), trace une ligne claire pour différencier le fonctionnement de la recherche orientée confirmation de théorie de celui d’une recherche design / développement (Figure 51).

La recherche design en éducation comprend aussi une perspective recherche action transformative, i.e. les chercheurs doivent essayer de changer les choses.

L'objectif de recherche global au sein de la tradition empirique est de développer des théories durables et des principes clairs qui peuvent être confiés aux professionnels pour leur mise oeuvre. La recherche développement, d'autre part, requiert une épistémologie pragmatique qui considère que la théorie de l'apprentissage est constamment façonnée par les chercheurs et les professionnels. L'objectif global de la recherche développement est de résoudre des problèmes réels tout en construisant des principes de design qui peuvent éclairer des décisions futures. Selon les termes de Kuhn, ce sont deux mondes bien différents. (Reeves, 2000: 12).

La cognition située et la complexité, i.e. les connaissances spécifiques à la situation, sont une autre caractéristique importante de la plupart des recherches design en éducation:

Un élément central de la recherche design en éducation comme travail appliqué implique de situer le travail dans des "contextes naturels". (Barab & Squire, 2004: 11)

Le plus couramment, les expériences de design impliquent à la fois de concevoir des formes particulières d'apprentissage et d'étudier systématiquement ces formes d'apprentissage dans le contexte défini par les moyens qui les supportent. Ce contexte crée est sujet à des tests et des révisions, et les itérations successives qui en résultent jouent un rôle similaire à celui de la variation systématique dans l'expérience. (Cobb, diSessa, Lehrer, & Schauble, 2003:9)

Pour en savoir plus sur la RDE, vous pouvez lire l’article de Class et Schneider (2013). La Recherche Design en Education : vers une nouvelle approche ?[1]

Les cartes de conjecture (Sandoval) pour organiser une RDE

La complexité et le caractère situé de la RDE sont liés à l'idée d'itération, i.e. les «expériences» en RDE ne sont pas réalisées une seule fois. Elles sont affinées puis à nouveau «testées» avec des utilisateurs afin d’essayer de comprendre les conjectures exprimées par les variables intermédiaires. Selon Sandoval (2004a:2), "La conception d’un environnement d'apprentissage comporte des «conjectures incarnées» sur l'apprentissage et l'enseignement, et l'étude empirique de ce type d’environnements permet d'affiner ces conjectures au fil du temps. Le concept de «conjectures incarnées» est une façon de démontrer la nature théorique de la conception d'environnements d'apprentissage, et d'encadrer les questions méthodologiques liées à l'étude de telles conjectures". Une conjecture incarnée est une conjecture sur la façon dont des propositions théoriques peuvent être réifiées au sein d'environnements conçus selon des méthodes sensées favoriser l'apprentissage. Les environnements ainsi conçus comprennent des outils (comme les logiciels), des matériels et des structures d'activités (que sont définies comme la combinaison de la structure des tâches, de comment une tâche est organisée, et des structures de participation sociale (Erickson, 1982)).

La RDE peut s'organiser grâce à des cartes de conjecture (Sandoval: 2004). Ces cartes permettent de conduire et d'organiser le projet de recherche avec une sorte de carte conceptuelle. Voici un exemple qui permet d'identifier les plus importantes composantes de recherche d'un cadre de rédaction collaborative. Il montre que la recherche est basée sur un ensemble de théories que nous essayons d'incarner dans un design, et que cela mène à des processus (cognitifs de l'apprenant) et, finalement, à des résultats (Figure 52).

Une telle carte peut et devrait être affinée au fil du temps, i.e. les flèches ne devraient pas simplement aller d'une grosse boîte à une autre, mais aussi relier les petites boîtes entre elles. L'idée est que certaines de ces relations devraient alors être testées avec une méthodologie de recherche sérieuse.

Dans la Figure 53, nous présentons un autre exemple qui montre une carte de conjecture pour une seule question de recherche: Dans quelle mesure la Structure de Support Tutoral aide-t-elle à concevoir un apprentissage socio-constructiviste efficace (Class, 2009)? Cet exemple montre qu'un certain nombre de conjectures théoriques définissent comment une structure de support tutoral devrait être mise en oeuvre. Ces éléments théoriques sont alors instanciés comme des conjectures incarnées, i.e. des règles de design pratiques. Les éléments de conception techno-pédagogiques devraient alors favoriser les processus, i.e. ce que les étudiants font. Ces processus devraient à leur tour mener à un meilleur apprentissage.

Comme vous pouvez certainement le déduire de ces deux exemples, de telles cartes de conjecture sont simplement une forme spéciale de carte conceptuelle pour définir des éléments de design et de recherche qui dépendent les uns des autres. En tant que tels, ils sont hautement idiographiques, i.e. les chercheurs doivent apporter leurs meilleures représentations, et cela dépend de l'objectif de recherche global. Il faut également noter que les cartes de conjecture devraient évoluer au fil du temps. E.g. dans le deuxième exemple, vous pouvez voir que les flèches définissent des relations entre des boîtes spécifiques. Ces relations peuvent alors être testées à l'aide de données (si disponibles).

Evaluation dans une recherche orientée design

L'évaluation n'est pas une problématique propre à la recherche orientée design. Examinons donc le principe général d’une recherche évaluation. Selon Frechtling et al (2002), cité par Randolph (2008:22), il existe un grand nombre de traditions d'évaluation parmi lesquelles choisir, mais une méthode standard pour conduire une évaluation est constituée des étapes suivantes:

- Développer un modèle conceptuel du programme et identifier les points d'évaluation clés,

- Développer des questions d'évaluation et définir des résultats mesurables,

- Développer un design d'évaluation,

- Recueillir les données,

- Analyser les données,

- Partager les résultats de la recherche avec les publics intéressés.

Les designs d’une recherche évaluation suivent souvent la même logique que les designs de recherche orientés vérification de théorie. En technologie éducative, l'évaluation utilise souvent comme référence une "règle technologique" et cela peut se traduire par une grille d'évaluation de haut niveau. Les principes premiers de Merrill (First Principles of Instruction) constituent un bon exemple:

1. L’environnement d’apprentissage utilise-t-il des problèmes authentiques?

2. L’environnement d’apprentissage permet-il d’activer des connaissances ou une expérience préalables?

3. L’environnement d’apprentissage montre-t-il ce qui doit être appris?

4. Les apprenants peuvent-ils pratiquer et appliquer les connaissances ou les compétences acquises?

5. Les apprenants sont-ils encouragés à intégrer (transférer) les nouvelles connaissances ou compétences dans leur vie quotidienne?

Un autre exemple est le LORI (Learning Object Review Instrument) disponible sous forme d'un formulaire en ligne consistant en des rubriques, des échelles d'évaluation et des champs de commentaires. Cet instrument d'évaluation est défini par neuf dimensions:

1. Qualité du contenu: véracité, exactitude, présentation équilibrée des idées et niveau de détail approprié.

2. Alignement de l'objectif d'apprentissage: alignement des objectifs d'apprentissage, des activités, des évaluations et des caractéristiques des apprenants.

3. Feedback et adaptation: contenus adaptatifs ou feedback conduit par une contribution différentielle de l'apprenant ou un modelage de ce dernier.

4. Motivation: capacité de motiver et de stimuler l'intérêt ou la curiosité d'une population d'apprenants identifiée.

5. Design de la présentation: conception des informations visuelles et auditives pour un apprentissage amélioré et un traitement mental efficace.

6. Utilisabilité de l'interaction: facilité de navigation, prédictibilité de l'interface utilisateur et qualité des fonctions d'aide de cette interface.

7. Accessibilité: soutien aux apprenants handicapés.

8. Réutilisabilité: capacité d'être transféré dans d'autres cours ou dans d'autres contextes d'apprentissage sans modification.

9. Conformité aux standards: Respect des standards et des spécifications internationaux

Bien entendu, les règles de design elles-mêmes qui sont derrière de telles grilles d'évaluation peuvent, elles-mêmes, faire l’objet d’une évaluation.

'Méthodologies d'évaluation'

Les questions de recherche types qu'un chercheur pourrait poser sont les suivantes:

- Dans quelle mesure les utilisateurs (e.g. les étudiants et leurs enseignants) sont-ils satisfaits d'un nouveau LMS?

- De quelles façons, d’un point de vue utilisateurs, une nouvelle intervention pourrait-elle être améliorée?

La méthodologie d’une recherche évaluation s'inspire des différentes approches des sciences sociales pour le recueil et l'analyse de données. E.g., Hkansson cite les méthodes de recueil de données suivantes: heuristique, expériences, questionnaires, entretiens, observations, et la pensée à haute voix.

Les méthodologies d'évaluation sont très différentes selon le type d'objet à évaluer et selon l'objectif de l'évaluation. Nous présenterons simplement deux cadres de travail pour l'analyse d'utilisabilité, car les études sur l'utilisabilité font habituellement partie de la recherche orientée design. Les artéfacts développés devraient être utilisables à la fois en termes d'utilisabilité de surface (les utilisateurs sont capables d'utiliser l'interface) et d'ergonomie cognitive (les utilisateurs sont capables d'utiliser l'interface pour réaliser une tâche réelle).

Exemple 1: Le modèle d'étude d'utilisabilité Usability Net

Usability Net (http://www.usabilitynet.org/) fournit un cadre de travail complet pour les études d'évaluation de l'utilisabilité. Les procédures d'utilisabilité sont incorporées à tous les stades de développement:

- Planning et faisabilité: pour garantir que les activités d'utilisabilité soient incorporées de manière efficace au design et au processus de développement, et qu'elles influencent les stades précoces de faisabilité du design et du processus de développement.

- Exigences: les utilisateurs et les développeurs identifient des exigences d'utilisabilité qui peuvent être testées plus tard dans le processus de développement.

- Design: créer et développer un design d'interface utilisateur qui est fondé sur la spécification des exigences, et qui vienne en aide à l'utilisateur dans les tâches à réaliser.

- Mise en oeuvre: garantir que le design détaillé tienne compte des principes d'utilisabilité.

- Tests et mesures: évaluer dans quelle mesure les exigences de l'utilisateur et de l'organisation ont été remplies, et fournir un feedback dans une forme qui peut être utilisée par les designers et les développeurs pour améliorer le design de l'interface utilisateur.

- Après le lancement / la mise en service: suivre l'utilisabilité du système après son lancement pour garantir qu'il répond aux besoins de l'utilisateur sur le terrain. Ce suivi devrait être utilisé comme données supplémentaires dans les exigences pour une nouvelle version ou parution.

La Figure 54: Cadre de travail Usability dresse la liste des méthodes qui peuvent être utilisées à chaque stade du design.

Pourquoi vous présenter ce modèle? Pour vous montrer que l'évaluation, dans un processus de conception, est fortement liée au processus de conception de l’ensemble de l’environnement. A chaque étape de la conception, il est nécessaire de penser à l'évaluation. Par exemple, si les utilisateurs ne participent pas à la phase "exigences", il sera difficile de mettre en oeuvre un programme de tests et mesures car on ne saura pas clairement quels critères utiliser.

Il existe d’autres approches pour étudier l’utilisabilité. Pour quelques détails, consulter: http://edutechwiki.unige.ch/fr/Utilisabilit%C3%A9 et http://edutechwiki.unige.ch/en/Methodology_tutorial_-_design-oriented_research_designs pour la méthode de Nielson par exemple.

Exemples de thèses de type design

Class, B. (2009). A blended socio-constructivist course with an activity-based, collaborative learning environment intended for trainers of conference interpreters. Université de Genève. http://archive-ouverte.unige.ch/unige:4780

Lombard, F. (2012). Conception et analyse de dispositifs d’investigation en biologie : comment conjuguer autonomie dans la validation scientifique, approfondissement conceptuel dans le paradigme et couverture curriculaire ? http://archive-ouverte.unige.ch/unige:24656

Ortoleva, G. (2015). Writing to share, sharing to learn: Technology-enhanced learning activities to foster professional development in initial vocational education. (Thèse en cours).

Résumé et pratique

Les designs de recherche orientés recherche design couvrent un large spectre de recherches. En technologie éducative, nous pouvons probablement faire la distinction entre trois types principaux:

- Les «Expériences de design» qui tentent de créer de nouveaux designs pédagogiques. Certains de ces derniers sont à grande échelle, i.e. s'étendraient sur le design d'un cours tout entier.

- Conception d'artéfacts technologiques, tels que les environnements d'apprentissage multimédia ou les environnements d'apprentissage virtuels.

- Modèles et langages de design d'apprentissage formels et semi-formels (règles de design).

Pour pratiquer:

- Pourquoi la "recherche design en éducation" a-t-elle émergé dans la technologie éducative au début des années 1990?

- Pour quelles raisons un chercheur peut-il réaliser une carte de conjectures? Quelles sont les finalités d’une carte de conjectures?

- Quel est le but du design participatif?

Exercice de révision

- Conduire une petite étude d'utilisabilité d'un outil pour enseignant afin de définir un design d'apprentissage. Télécharger et installer http://compendiumld.open.ac.uk/ CompendiumLD. Préalablement, il faut installer JAVA (si Java n'est pas déjà installé sur votre machine)

- Appliquer grossièrement la procédure suivante:

- Ecrire une liste d'exigences / de besoins

- Concevoir une séquence de formation (une aide est incluse dans le système)

- Concevoir une séquence de test

- Réaliser ces tests avec 2 utilisateurs

- Faire des suggestions sur les fonctionnalités manquantes et les problèmes d'utilisabilité

Etude de cas

- Télécharger l’article de Class, B. et Schneider. D. (2012). Design, mise en oeuvre et évaluation d’une formation hybride. Distances et Médiations des Savoirs, Vol. 1, p. 1-27. http://archive-ouverte.unige.ch/unige:34461

- Identifier l’objectif principal de l’étude.

- Identifier et décrivez la méthodologie utilisée pour conduire cette recherche de type Recherche Design en Education.

- Identifiez de 1 à 5 règles de design (règles de conception) qui pourraient être intéressantes pour votre contexte. Expliquez en quoi et pourquoi elle(s) pourraient être intéressantes.

- Esquissez un design de recherche de votre choix (orientée vérification de théorie, formulation de théorie ou design) pour utiliser une des règles de design identifiées comme intéressante pour votre contexte.

Références et bibliographie

- ↑ Class et Schneider (2013). La Recherche Design en Education : vers une nouvelle approche ? Frantice.net, vol. 7, p. 5-16. http://archive-ouverte.unige.ch/unige:34459.