« Béhaviorisme » : différence entre les versions

(Page créée avec « '''Ceci est une synthèses des articles originaux disponibles sur''' : http://deliriumstudens.org/wiki/index.php =Introduction= Le béhaviorisme (ou comportementalisme) ... ») |

|||

| Ligne 82 : | Ligne 82 : | ||

*Pour une simulation, voir le lien suivant: [http://www.uwm.edu/~johnchay/ccFrench.htm] | *Pour une simulation, voir le lien suivant: [http://www.uwm.edu/~johnchay/ccFrench.htm] | ||

== Le processus: acquisition d’une réponse de conditionnement classique == | == Le processus : acquisition d’une réponse de conditionnement classique == | ||

Le stimulus conditionnel ne provoque pas immédiatement une réponse. Dans le cas des chiens de Pavlov, c'est | Le stimulus conditionnel ne provoque pas immédiatement une réponse. Dans le cas des chiens de Pavlov, c'est après trois fois que le stimulus conditionel (un son de cloche ou une lumière) provoque une réponse conditionnelle (la salivation). Cette réponse conditionnelle est stabilisée après quatre à six répétitions. | ||

== Les concepts de base == | == Les concepts de base == | ||

Version du 30 juillet 2013 à 13:28

Ceci est une synthèses des articles originaux disponibles sur : http://deliriumstudens.org/wiki/index.php

Introduction

Le béhaviorisme (ou comportementalisme) définit l’apprentissage comme une modification durable du comportement résultant de la conséquence d’un entraînement particulier.

Le terme « béhavioriste » fut utilisé pour la première fois par John B. Watson en 1913 dans un article portant sur la nécessité d’observer les comportements pour pouvoir les étudier.

Plus tard, B.F. Skinner développa le concept de conditionnement opérant (initié au départ par Edward Thorndike, 1913) qu’il distingue du conditionnement pavlovien ou classique (Pavlov, 1901).

En effet, dans le conditionnement classique, un stimulus dit conditionnel (le bruit d’une cloche, par exemple) est associé à un stimulus inconditionnel (de la nourriture, par exemple) pour produire une réponse conditionnelle (telle que la salivation).

Ici, la salivation est considérée comme une réaction inconditionnelle parce qu'elle est provoquée par la vue de la nourriture. Néanmoins, si elle est provoquée uniquement par le son, la salivation est alors considérée comme une réaction conditionnelle.

Il est important de noter toutefois qu’ici que le comportement de salivation correspond à une réaction que le sujet ne contrôle pas et n’est pas le résultat d’un apprentissage volontaire d’un nouveau comportement.

Dans le conditionnement opérant de Skinner, la réponse n’est pas une réaction automatique de l’organisme mais est déclenchée par le sujet.

Le conditionnement classique

La théorie d'apprentissage

Définition: « L’apprentissage désigne un changement relativement stable du comportement, hors du répertoire comportemental, qui se manifeste en fonction des expériences. »[1].

Ceci dit, il est possible d'apprendre quelque chose sans que ça ne se manifeste dans le comportement.

Ainsi, si une personne arrive en retard à l'arrêt de bus plusieurs fois, son comportement changera.

Principes guidant le courant béhavioriste

Des préférences et des aversions naturelles guident l’apprentissage.

- Trois principes généraux de l'apprentissage:

- L’expérience forme le comportement (il y a des comportements innés, mais la plupart des réactions des êtres humains sont acquises).

- L’apprentissage est adaptatif (l'environnement n'étant pas stable, la nature élimine les organismes non-adaptés. L'apprentissage est en outre réversible en fonction de l'environnement).

- Il est possible de découvrir les lois d’apprentissage grâce à des expériences systématiques (aussi bien pour les animaux que pour les êtres humains).

- Aristote (ca. 400 av. J.C.) a déjà proposé des lois d’association expliquant les conditions sous lesquelles une pensée peut se connecter avec une autre (contiguïté et similarité).

Un cas exceptionnel : l'empreinte

- L’empreinte est la seule forme d’apprentissage qui est irréversible.

- Elle est basée sur un instinct et se passe seulement dans une certaine fenêtre temporelle.

- Sa fonction est la fixation sur un objet dans l’environnement comme guide pour la survie.

Figures 2 & 3. ULM accompagnant des oies et des grues « imprimées »[2].

Exemple: l'empreinte des canards

- Pour les canards, l’empreinte se passe entre 11 et 18 heures après la naissance. Plus tard, l’empreinte n’est plus possible à cause du développement de la peur[3].

Les études d'Ivan Pavlov (1898) : une découverte due au hasard

Ivan Pavlov est le père du mouvement béhavioriste, grâce à ses expériences sur les chiens dont la salivation n'est pas exclusivement causée par la présence de nourriture, mais également par un bruit annonçant l'arrivée de la nourriture (pour autant que celui-ci ait été associé à la nourriture au préalable). Ce type de comportement est aujourd'hui connu sous le nom de « conditionnement classique ».

Le conditionnement classique : concepts-clés

- Pavlov (1898) a étudié les réflexes tels que la salivation au cours de ses recherches dans le domaine de la physiologie de la digestion. Trois concepts-clés se dégagent de ses études :

- Un réflexe est un comportement déclenché automatiquement par un stimulus environnemental et qui se manifeste sans contrôle volontaire (tel que le réflexe rotulien ou myotatique, le clignement d’yeux, le réflexe de préhension).

- Un stimulus est un élément de l’environnement qui provoque une réaction.

- Une réaction est une réponse comportementale à un stimulus.

L'observation de Pavlov

- Le tintement d’une cloche est produit à chaque fois que le chien va être nourri et provoque la salivation – la même réaction que la nourriture.

- Le chien a été « conditionné » pour réagir au son de la cloche.

- Le chien a appris à associer la cloche à la nourriture.

- En termes de théorie de l’apprentissage, un nouveau stimulus – la cloche – peut provoquer une réaction – le réflexe de salivation.

- Le principe du conditionnement classique est donc la substitution d’un stimulus (la nourriture) par un autre (la cloche).

- Pour une simulation, voir le lien suivant: [3]

Le processus : acquisition d’une réponse de conditionnement classique

Le stimulus conditionnel ne provoque pas immédiatement une réponse. Dans le cas des chiens de Pavlov, c'est après trois fois que le stimulus conditionel (un son de cloche ou une lumière) provoque une réponse conditionnelle (la salivation). Cette réponse conditionnelle est stabilisée après quatre à six répétitions.

Les concepts de base

(I) Les termes importants à retenir:

- Stimulus inconditionnel (S.I.) = naturel. Qui peut activer une réaction sans apprentissage (inconditionnelle).

- Par exemple la nourriture.

- Une réaction inconditionnelle (R.I.) est un réflexe qui se produit naturellement et sans apprentissage.

- Par exemple la salivation.

- Un stimulus neutre (S.N.) est un stimulus qui n’entraîne normalement pas de réflexe de manière naturelle

- Par exemple un son de cloche.

(II)

- Le conditionnement classique (ou conditionnement pavlovien) est la forme d'association d'un stimulus neutre avec une réaction inconditionnelle. Il y a donc substitution du stimulus inconditionnel par le stimulus neutre.

- Un stimulus conditionné (S.C.) est un stimulus qui peut évoquer un réflexe suite à un apprentissage.

- Une réaction conditionnelle (R.C.) est la réaction (et non un réflexe) apprise – manifestation du réflexe suite à la présentation d’un stimulus conditionné.

Réflexe = non appris

Réaction = appris

Le processus du conditionnement classique

Le béhaviorisme est la base de toutes les thérapies comportementales.

Aversions gustatives conditionnées

- L’aversion est conditionnée en associant un goût (S.N.) à une expérience déplaisante, généralement la nausée (R.I.) – « García effect ».

- Par exemple le goût qui est associé à la nausée. Ce n'est pas le goût en soit qui a causé la nausée, mais c'est ce qui y a été associé.

- C'est un conditionnement très rapide: deux présentations de la nourriture appariées à la nausée suffisent[5].

- La plupart du temps, la capacité de développer une aversion gustative conditionnée est adaptative – apprentissage d’éviter des nourritures toxiques → facilitation de l’adaptation dans un environnement complexe.

- L’apprentissage des aversions gustatives fonctionne aussi sans intervention de la conscience[6]:

- Les rats ayant subi une ablation du cortex et les animaux complètement anesthésiés peuvent encore apprendre des aversions gustatives induites par des nausées.

Réactions émotionnelles apprises

Presque toutes les phobies sont expliquées par des réactions émotionnelles apprises (phobie des araignées, serpents, etc.)

- Une réaction émotionnelle conditionnée est le résultat d’une substitution d’un stimulus qui naturellement provoque une réaction émotionnelle par un stimulus neutre.

- Explication pour le développement de troubles émotionnels tels que les phobies.

- Étude du « Petit Albert » par Watson et Rayner (1920):

- conditionnement de la peur (R.C.) chez un enfant de neuf mois par l’association d’un rat (S.N.) avec un stimulus aversif (S.I.).

Petit Albert[7]

Une des nombreuses vidéos disponible sur Youtube: [4])

- S.N.: avant le conditionnement Albert joue avec des objets velus tels qu’un rat, un lapin, un masque de Père Noël.

- S.I.: faire retentir une barre métallique directement derrière sa tête en présence des S.N.

- R.I.: Albert saute, tombe et pleure.

- Conditionnement: association d’un rat (S.N.) avec un stimulus aversif – un fort bruit (S.I.): chaque fois que Albert tente d’approcher le rat, les chercheurs font retentir la barre métallique.

- R.C.: après 7 associations, Albert pleure en présence du rat.

- La même réaction s’observe en présence d’autres objets velus 5 jours après le conditionnement et aussi 26 jours plus tard.

Tout un paradigme ou vue de la possibilité de former les gens. Ce n'est pas notre destin qui détermine notre avenir. On peut les façonner. Mais il faut voir ça dans le contexte de l'époque de psychanalyse, introspection, etc.

Le conditionnement de la peur

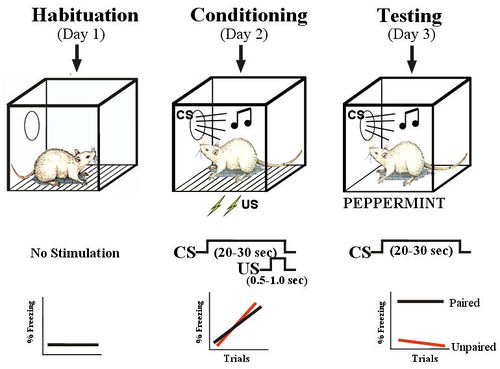

Le conditionnement de la peur chez le rat:

- un rat est placé dans une boîte avec un sol grillagé (des chocs électriques peuvent être envoyés à la grille).

- d'abord on fait retentir un son seul, le rat se retourne.

- ensuite on associe le son au choc électrique

- finalement, le rat réagi au son (le rat a peur) bien qu'il n'y ait plus de choc électrique.

Fear Conditioning. Fear conditioning occurs in three phases.

1. In habituation the rat is acclimated to the chamber. No stimuli are presented.

2. During conditioning the tone conditioned stimulus (CS) is paired with the footshock unconditioned stimulus (US).

3. Testing then involves presentation of the CS without the US the next day.

Typically, the rat exhibits freeing responses to the CS during the test. If the rats received unpaired presentations of the CS and US during conditioning, they freeze little to the CS, indicating that they did not come to associate the CS with the US.[8]

Le conditionnement opérant

La contribution théorique majeure de B.F. Skinner (1904-1990) à la psychologie est le concept de conditionnement opérant, qu'il distingue du conditionnement classique pavlovien ou conditionnement répondant (terme qu'il invente lui-même). Une classe de comportement constitue un opérant si la probabilité d'apparition de ces réponses est modulable par la manipulation des contingences de renforcement. En clair, on dira qu'une action est conditionnée de manière opérante quand sa fréquence augmente dans le comportement d'un organisme du fait de ses conséquences positives pour l'organisme. Dans le conditionnement classique un stimulus entraîne une réponse, dans le conditionnement opérant, on renforce une réponse par la manipulation des contingences.

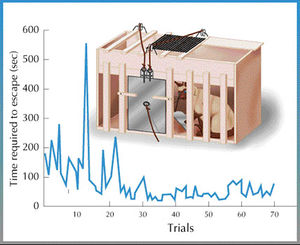

L’étude de Edward Thorndike (1898)

- Un chat se trouve dans une cage munie d’un levier mécanique (le « puzzle box »); à l’extérieur, de la nourriture est placée bien en vue.

- Le chat explore la cage. Par hasard, il trébuche sur le levier, la porte de la cage s’ouvre et le chat accède à la nourriture.

- Que se passe-t-il si le chat est remis dans la cage?

- Le chat devient de plus en plus expert pour manipuler le levier et quitte la cage dès que la nourriture est présentée.

C'est dans la cave de Mr. James qu'Edward Thorndike a inventé le « puzzle box ». Un chat affamé est placé dans cette boîte fermée. De la nourriture est placée bien en vue de l'animal. Tout d'abord le chat explore le terrain. Il n'est pas « équipé » pour savoir comment ouvrir la boîte, il n'est pas « équipé » pour suivre un but. Mais, au bout d'un certain temps, par accident il réussit à ouvrir la porte et accède à la nourriture. En remettant le même chat, dans la même boîte le jour suivant, le chat réussit à ouvrir la boîte un peu plus vite que la première fois. Chaque jour, ou presque, le chat ouvre la boîte un peu plus vite.

Loi de l'association, entre un stimulus neutre (SN) et inconditionné (SI).

La courbe d'apprentissage

- Le conditionnement instrumentaire

- Dans un premier temps, le chat met un certain temps pour réussir à sortir par hasard de la boîte.

- Dans un second temps, le temps qu'il met pour sortir chute.

- Puis, typiquement, il y a un ralentissement.

- Finalement, le temps que le chat met à sortir réduit jusqu'à se stabiliser.

- Courbe logarithmique.

- Après 4-5 essais, il y a une stabilisation du comportement.

- Ce n'est pas un comportement naturel, mais une adaptation.

La « loi de l’effet »

- Sur la base de ses observations, Thorndike (1911) a proposé une importante loi de l’apprentissage: « la loi de l’effet ».

- La loi de l’effet est la tendance d’un animal à reproduire un comportement en conséquence des effets de ce comportement sur l’environnement et de l’impact de ces effets sur l’animal - le comportement est donc une fonction de ces conséquences.

- La tendance d’un animal à reproduire un comportement dépend des effets de ce comportement sur l’environnement et de l’impact de ces effets sur l’animal - le comportement est donc une fonction de ces conséquences.

- Le comportement est un effet de ses conséquences (« Law of effect »). Tous les comportements on un effet sur d'autres comportements et ainsi de suite.

- Thorndike a nommé ce processus de l’apprentissage le « conditionnement instrumental » parce que le comportement avait un caractère instrumental dans l’accomplissement d’un but – la satisfaction (p.ex. obtenir de la nourriture).

- Le conditionnement instrumental, d'ailleurs plutôt appelé « conditionnement opérant », est un comportement utile pour obtenir quelque chose, mais cela implique un apprentissage, ce qui n'est pas naturel.

Thorndike très influent, a réfléchi aux règles derrière ses observations. Il a formulé une loi appelée la « loi de l'effet » (« law of effect »). D'ailleurs, l'économie est basée là-dessus.

B.F. Skinner (1938, 1953): le conditionnement opérant

Skinner (1904-1990) est resté « black box » (boîte noire), jusqu'à la fin de sa vie.

- Sur la base de ses nombreuses expériences (surtout avec des pigeons et des rats), Skinner a systématisé la façon dont le comportement est contrôlé par l’environnement selon la « loi de l’effet ».

- Position behavioriste radicale: explication du comportement sans utilisation de concepts mentaux.

- Pas d'attentes, pas de sentiments. Il a aussi changé la terminologie de Thorndike « conditionnement instrumental ». Il faut tout expliquer avec ce qu'on peut observer à la surface. Il a appelé ça le « conditionnement opérant ».

- Introduction du terme « conditionnement opérant » qui signifie que le comportement opère sur l’environnement afin de produire une conséquence.

- Les opérants sont des comportements émis (produits spontanément) plutôt que générés par l’environnement.

Skinner (1938): 3 suppositions fondamentales

- Les animaux sont très fréquemment actifs – par conséquent les organismes manifestent des comportements d’une manière continue.

- Les conséquences des comportements influencent la probabilité avec laquelle ces comportements seront répétés à l’avenir.

- L’état motivationnel de l’organisme et son environnement physique et social influencent l’efficacité de ces conséquences.

- Par exemple, l’efficacité de la nourriture pour augmenter la probabilité d’un comportement dépend de la durée de la privation de la nourriture.

S'il n'y a pas un état qui pousse un organisme à avoir un comportement, il n'y aura pas d'apprentissage.

Reforcement et punition

L'apprentissage skinnerien repose sur deux éléments, le renforcement et la punition, pouvant chacun être soit positif soit négatif. Ces termes doivent être pris dans le sens précis du conditionnement opérant :

- Renforcement : Conséquence d'un comportement qui rend plus probable que le comportement soit reproduit de nouveau.

- Punition : Conséquence d'un comportement qui rend moins probable que le comportement soit reproduit de nouveau.

Un renforcement ou une punition peut être soit :

- Positif : Par l'ajout d'un stimulus agissant sur l'organisme.

- Négatif : Par le retrait d'un stimulus agissant sur l'organisme.

Les différents types de conditionnement opérant

Ainsi, il existe 4 types de conditionnement opérant :

- Renforcement positif : Procédure par laquelle la probabilité de fréquence d'apparition d'un comportement tend à augmenter suite à l'ajout d'un stimulus appétitif contingent à la réponse. Ex: Ajout d'une récompense, félicitations...

- Renforcement négatif : Procédure par laquelle la probabilité de fréquence d'apparition d'un comportement tend à augmenter suite au retrait d'un stimulus aversif contingent à la réponse. Ex: Retrait d'une obligation, d'une douleur...

- Punition positive : Procédure par laquelle la probabilité de fréquence d'apparition d'un comportement tend à diminuer suite à l'ajout d'un stimulus aversif ou conséquence aversive contingente au comportement cible. Ex: Ajout d'une obligation, d'une douleur...

- Punition négative : Procédure par laquelle la probabilité de fréquence d'apparition d'un comportement tend à diminuer suite au retrait d'un stimulus appétitif. Ex: Retrait d'un privilège, d'un droit...

Les renforçateurs

Il existe 2 sortes de renforçateurs (éléments de renforcement) :

- Renforçateur primaire : Le renforçateur répond directement à un besoin essentiel de l'individu. Ex: Nourriture... On peut le comparer au stimulus inconditionnel de Pavlov (même si, là, il a un rôle a posteriori

- Renforçateur secondaire : Le renforçateur est un renforçateur par un certain apprentissage fait au préalable. Ex: Jouet, argent...

Schéma du conditionnement opérant

Renforcement positif

- Un renforçateur (SR) est une conséquence environnementale qui se produit après la réaction d'un organisme et qui rend la réapparition de cette réponse (R) plus probable.

- Le renforcement positif est le processus par lequel la présentation d'un stimulus après un comportement augmente la probabilité que ce comportement se produise à nouveau.

- Dans l'étude de Thorndike (1898), par exemple, la nourriture était le renforçateur pour appuyer sur le levier. (Skinner a répliqué l'étude avec des pigeons dans une « Skinner box »).

Un renforcement positif ne veut pas dire que c'est quelque chose d'agréable. Le renforcement augmente la probabilité de faire quelque chose, la punition diminue cette probabilité.

Il faut définir le comportement cible pour changer le comportement actuel. Le renforcement est positif parce que je « donne » quelque chose qui augmente la probabilité de faire quelque chose.

Renforcement négatif

- Le renforcement négatif est le processus par lequel l’élimination d’un stimulus après un comportement augmente la probabilité que ce comportement se produise à nouveau.

- L’apprentissage d’échappement est un renforcement par l’élimination d’un événement aversif déjà existant: si j'enlève quelque chose qui n'est pas agréable, ça fonctionne comme renforçateur. Élimination d'un élément aversif (dissuasif) déjà existant.

- Exemples:

- Un rat apprend d’appuyer sur un levier pour interrompre une stimulation douloureuse comme un choc électrique ou du bruit.

- Un enfant apprend à ranger sa chambre pour ne plus entendre ses parents rouspéter.

- Exemples:

- L’apprentissage d’évitement est un renforcement par l’élimination d’un événement qui est signalé par avance.

- Exemples:

- Un rat apprend d’appuyer sur un levier si un son signale qu’un choc électrique va suivre.

- Un enfant apprend de ranger sa chambre avant d’entendre ses parents rouspéter.

- Exemples:

Un renforcement négatif ne veut pas dire que c'est quelque chose de désagréable. Le renforcement augmente la probabilité de faire quelque chose, la punition diminue cette probabilité.

Punition positive et négative

- Une punition (SP) est une conséquence environnementale d’un comportement qui diminue la probabilité d’une réponse (R).

- Comme pour le renforcement, il y a des punitions positive et négative.

- Dans la punition positive, un stimulus aversif est présenté.

- Exemples:

- Le choc électrique. Un rat fait quelque chose d'appris ou par hasard, il y a une conséquence douloureuse. C'est ce qu'on appelle la punition positive: un stimulus aversif (dissuasif) est présenté.

- Le rat évite d’appuyer sur un levier après avoir obtenu un choc électrique.

- Un enfant ne fait plus de désordre dans sa chambre après avoir entendu ses parents rouspéter.

- Exemples:

- Dans la punition négative, un stimulus agréable est éliminé.

- par exemple un employé qui n’obtient pas d’augmentation de salaire à cause de ses fréquents retards.

Problèmes du renforcement et de la punition

- L’organisme doit savoir exactement quel comportement est renforcé ou puni. Il faut connaître des « contingences ».

- Un des problèmes de la punition est la difficulté à distinguer quel opérant a été puni.

- Par exemple, les « experts » qui appellent plusieurs fois de suite leur chien (ou un enfant) et lui crient dessus parce qu’il n’est pas venu tout de suite punissent le bon comportement – venir après l’appel.

- À long terme, l’extinction et plus efficace que la punition positive[9]. Après la punition positive est terminée, il y a fréquemment une récupération spontanée.

Skinner utilisait plutôt le renforcement. On peut contrôler le comportement, mais on ne peut pas vraiment effacer quelque chose.

Par exemple, avec un chien, il faut l'appeler et donner de la nourriture (le renforçateur) seulement s'il vient (même si cela prend du temps). Il ne faut jamais aller vers lui, parce que c'est ça qui va renforcer son comportement. Il faut savoir ce qu'il faut renforcer. Cela veut dire que même si le chien met du temps à venir (si c'est le comportement que l'on veut renforcer), il faut lui donner sa récompense (ce qui renforcera son comportement). Donc, la contingence s'il vient avec du « retard » est de le récompenser.

On peut confondre un organisme en punissant un comportement qu'il faudrait renforcer.

À long terme Skinner, qui était contre la punition, dit que l'extinction est plus efficace que la punition positive. La punition marche si on peut l'appliquer, mais il faudrait toujours être en mesure de punir (un peu comme les systèmes fasciste ou communiste).

Ça demande du courage (et de la patience) de ne rien faire. Un comportement complètement puni devient peu intéressant si on ne fait rien.

L’équipement de recherche: la fameuse « Skinner box »

Skinner a développé la « Skinner box », qui est une boîte avec un fond en général métallique permettant d'envoyer des secousses électriques. Néanmoins Skinner n'a pas beaucoup travaillé avec la punition, il était un fervent utilisateur de la récompense. La « boîte de Skinner » est utilisée sans intervention de l'expérimentateur: machine et animal. Il faut juste définir la réaction voulue pour cause donnée. Un pigeon ou un rat peut être placé dans une de ces boîtes et, par exemple, un renforcement peut être créé lorsque l'animal appuie sur un levier (en général en obtenant de la nourriture).

vidéo de l'expérience de skinner

L’étude de Estes (1944): la punition et l’extinction

Estes a comparé l'efficacité de la punition vs l'extinction.

- D’abord, des rats sont renforcés avec de la nourriture pour appuyer sur un levier.

- Le rat: « si j'appuie sur ce truc, ça fait du bien. »

- Puis, on forme deux groupes (on ne veut plus que le rat appuie sur le levier):

- Punition: au cours d’une session, des chocs électriques sont délivrés suite à appuyer sur le levier.

- Extinction: au cours d’une session, il n’y a plus de renforcement (il n'y a plus de nourriture).

- Puis on observe les rats au cours de quatre jours d’extinction.

- Mesure: fréquence d’appuyer sur le levier.

- Résultat (figure 5): la punition réduit le comportement cible (appuyer sur le levier), mais puis il y a une récupération spontanée.

Au bout de quatre jours, donc, on arrive au même résultat avec les deux méthodes. La punition est efficace mais il faut toujours être en mesure de pouvoir punir. À court terme la punition marche, mais avec des frais élevés. Elle ne donne pas d'avantage à long terme. La punition ne peut pas effacer un comportement.

D'autres problèmes

- Un autre problème de la punition est l’association de la peur de celui qui apprend avec la personne qui punit (via le conditionnement classique) plutôt qu’avec sa propre activité (via le conditionnement opérant).

- Le parent qui puni est associé avec la punition. Ça rend la vie sociale difficile. Les relations ambigües avec le maître, les parents, etc. Du coup, la punition est l’association de la peur de celui qui apprend avec la personne qui punit (via le conditionnement classique) plutôt qu’avec sa propre activité (via le conditionnement opérant).

- La punition ne peut pas éliminer les récompenses déjà existantes pour un comportement (p.ex. punition d’un enfant qui suce son pouce).

- La punition ne peut jamais complètement éliminer le comportement une fois qu'il est établi.

- La punition peut seulement supprimer le comportement, mais pas l'éliminer.

- Si on a un enfant qui suce son pouce, la punition peut arrêter le comportement, mais pas éliminer le plaisir qu'il en tire.

- « L’apprentissage secondaire » - un enfant puni apprend qu’on peut résoudre des problèmes par voie d’agression.

- La punition est seulement efficace lorsqu’elle est accompagnée d’un raisonnement et d’un comportement alternatif qui est renforcé.

Renforcement et punition en bref

| Renforcement | Punition | |

|---|---|---|

| Positif | Présentation d'un stimulus « agréable » | Présentation d'un stimulus « aversif » |

| Négatif | Élimination d'un stimulus « aversif » | Élimination d'un stimulus « agréable » |

Rappel: les termes « agréable » et « aversif » dépassent les concepts utilisés selon la perspective du behaviorisme classique.

Un regard plus détaillé

| Type | Definition | Effect | Example |

|---|---|---|---|

| Positive reinforcement | Delivery of a pleasant or appetitive stimulus following a behavioral response | Increase the frequency of the behavioral response | If studying is followed by a high grade on an exam, then the incidence of studying before exams will increase |

| Negative reinforcement | Removal of an unpleasant or aversive simulus following a behavioral response | Increase the frequency of the behavioral response | If leaving a study area removes you from a noisy classmate, then the time you spend away from the study area will increase |

| Positive punishment ("punishment") | Delivery of an unpleasant or aversive stimulus following a behavioral response | Decrease the frequency of the behavioral response | If your professor embarrasses you for asking a question in class, then the likelihood you will ask questions in class will decrease |

| Negative punishment ("omission training") | Removal of a pleasant or appetitive stimulus following a behavioral response | Decrease the frequency of the behavioral response | If your girl- or boyfriend withholds affection whenever you watch TV, the time you spend in front of the TV will decrease. |

Comment peut-on changer une réaction conditionnée?

Il y a au moins trois stratégies pour changer ou éliminer des réactions conditionnées:

- L'extinction: rien faire, mais ça demande beaucoup de patience (p.ex.: ignorer le mauvais comportement d'un enfant).

- La punition: présenter une conséquence dissuasive (« aversive consequence ») ou éliminer une conséquence agréable du comportement.

- Le contre-conditionnement: renforcer un comportement incompatible (p.ex. féliciter un enfant d’être assis afin d’éliminer son habitude de courir partout).

Et l’être humain ?

La théorie du conditionnement opérant de Skinner nous permet d'établir un lien direct entre béhaviorisme et pédagogie. Les autres théoriciens (Pavlov, Watson) s'étaient intéressés jusque-là aux mécanismes d'apprentissages, tant humains qu'animaux, mais n'en avaient pas tiré d'application concrète à destination de l'enseignement. Skinner, nous le verrons, tirera des applications pédagogiques de ses théories. Mais commençons d'abord par examiner ce que signifie l'apprentissage pour ce dernier.

Pour Skinner, l’efficacité de l’apprentissage est liée à six principes : • le principe de la participation active : le sujet doit construire sa réponse et non la choisir ; • le principe des petites étapes : il faut fragmenter la difficulté pour que même les plus faibles puissent répondre ; • le principe de progression graduée ; • le principe de l’allure personnelle : chacun doit pouvoir avancer à son rythme ; • le principe des réponses correctes : trop d’échecs découragent les élèves, il faut les guider.

L’enseignement programmé

Skinner critique l’enseignement classique. Ses travaux en psychologie du comportement soulèvent l’importance d’un renforcement pour l’apprentissage. Pour lui, ce renforcement est fondamental et doit être immédiat, or, dans les classes habituelles, le délai est très long, trop long. De plus, pour lui, le renforcement ne s’intègre pas dans une suite logique d’activités qui permettrait à l’élève d’apprendre un comportement complexe. Enfin, les renforcements sont trop rares, ceci étant lié essentiellement au fait que de nombreux élèves dépendent d’un même enseignant. Il propose donc de réformer cette école, en partant des résultats du conditionnement opérant, en tant que théorie du contrôle des mécanismes d'apprentissage. Il envisage ainsi la création d'une technologie scientifique de l'enseignement qui utilise l'enseignement programmé, susceptible d'être dispensé par une machine à enseigner. La machine à enseigner de Skinner est une boîte parallélépipédique dans laquelle se trouve un rouleau de papier. L’élève commande le déroulement de la bande par la molette se trouvant sur le devant. Les questions apparaissent ainsi une par une ouverture dans la fenêtre. L’élève inscrit sa réponse sur un espace blanc réservé à cet effet, puis tourne la molette. Ceci lui permet de voir la réponse. Il compare ainsi son résultat à la réponse fournie et, si elle est juste, il actionne un levier qui, par perforation de la feuille de programmation, enregistre les bonnes réponses. Puis, il passe à la question suivante. Dans la machine de Skinner, l’enseignement est apporté par la correction immédiate. Mais il s’agit avant tout de machines d’auto-évaluation et non de support de connaissances au sens où nous l’entendons habituellement. La machine propose en outre un enseignement linéaire, en aucun cas la réponse de l’élève ne peut influencer le choix de la question suivante. Pour Skinner (1968), « l’élève doit composer lui-même sa réponse, plutôt que de la choisir parmi plusieurs possibilités, comme c’est le cas dans les dispositifs à choix multiples ». En effet, il pense que le Q.C.M entraîne des erreurs que l’élève n’aurait jamais commises sans cette suggestion. De plus, dans la machine de Skinner c’est l’élève qui s’auto-corrige en comparant sa réponse à celle du programme. Enfin, dans ces machines, bien que Skinner prône le renforcement, il juge qu’un renforcement extérieur n’est pas nécessaire car les renforcements intrinsèques de la réussite et du progrès sont suffisants et inépuisables.

Vidéo sur la machine à apprendre

Notes & Références

Crahay,M. (1999).Psychologie de l'éducation. Paris : PUF

O’SHEA, T. & SELF, J. (1983). Learning and Teaching with Computers - Artificial Intelligence in Education. Brighton: Harvester Press.

PAVLOV, I.P. (1901). Le travail des glandes digestives. Paris Masson et Cie.

SKINNER, B.F. (1971). L’analyse expérimentale du comportement, un essai théorique. Bruxelles, C. Dessart.

THORNDIKE, E. (1913). Educational Psychology: The Psychology of Learning. New York: Teachers College Press.

WATSON, J.B. (1913). Psychology as the behaviorist views it. Psychological Review, 20, pp. 158-177.