OnTask

Introduction

OnTask est un outil qui a pour but d'améliorer l'expérience des étudiants à l'université grâce à des envois, au moment opportun, de feedbacks personnels et actionnables lors de leur participation à un cours. C’est un outil Open Source disponible sur Github développé par une équipe de chercheurs australiens menée par Abelardo Pardo en 2018. Il rejoint très vite le programme d’incubation d’Apereo, une fondation internationale dont le but est de promouvoir le développement de logiciels innovants dans le domaine de l’éducation. Ce logiciel est par la suite adopté par de nombreuses universités aussi bien en Australie qu’aux Etats Unis ou en Grande Bretagne.

Fonctionnement de l’outil

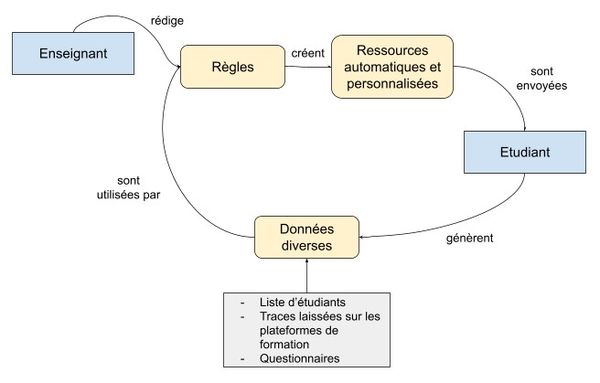

Le fonctionnement de cet outil novateur peut être résumé simplement : les enseignants rédigent des règles simples qui définissent quels étudiants reçoivent quel feedback en fonction de données récoltées de différentes manières. Il y a donc deux types d’utilisateurs de ce logiciel : l’enseignant est un utilisateur direct, il intervient sur l’outil et l’étudiant est un utilisateur indirect, l’outil lui transmet un feedback sous différentes formes. La figure 1 résume ce fonctionnement.

Les données

Les données analysées peuvent provenir de LMS (Learning Management System), quizz, annotation de vidéo ou questionnaires remplis par les étudiants. En effet, avec la digitalisation de nombreuses formations universitaires, il est possible d’obtenir des traces d’interactions des étudiants avec le système (ou la plateforme) de formation. Les traces obtenues sur les LMS peuvent être des séquences d’actions effectuées par les étudiants, les solutions aux exercices proposés, des annotations de vidéos, des discussions sur des forums ou des chats ou le contenu d'exercices de rédaction. A cela s'ajoutent d’autres données provenant des systèmes administratifs de l’université ou d’observations directes de l’enseignant par exemple. Ces données sont téléchargées et conservées dans le logiciel dans des tables de données, une entité appelée “Data Warehouse”.

Une fois récoltées, les données sont nettoyées et transformées. Il faut pour cela ne garder que les informations pertinentes pour l’enseignant (et pour l’objectif d’apprentissage) et en faire des indicateurs faciles à utiliser. Un tableau permet ensuite de faire le bilan de la liste d’élèves liées aux différents attributs utiles pour l’enseignant. Ce tableau est nommé le “student data table” ou SDT, en français : la table de données des étudiants. Il sera utilisé par l’enseignant pour établir les règles à appliquer pour fournir le feedback.

De nouvelles données peuvent aussi être créées dans ce SDT grâce à des algorithmes qui produisent un modèle statistique pour créer des classifications ou des modèles d’étudiants.

Les règles

Les règles sont créées selon le modèle simple du “si X alors Y”. Si un étudiant remplit une condition alors il reçoit un feedback. Si un autre étudiant remplit une autre condition, alors il reçoit un autre feedback. Les données X et Y sont les attributs de la SDT. Les règles peuvent utiliser plusieurs attributs liés par “AND” ou “OR” mais aussi par des égalités (EQUALS) ou inégalité (NOT). Des filtres peuvent y être ajoutés.

Les actions

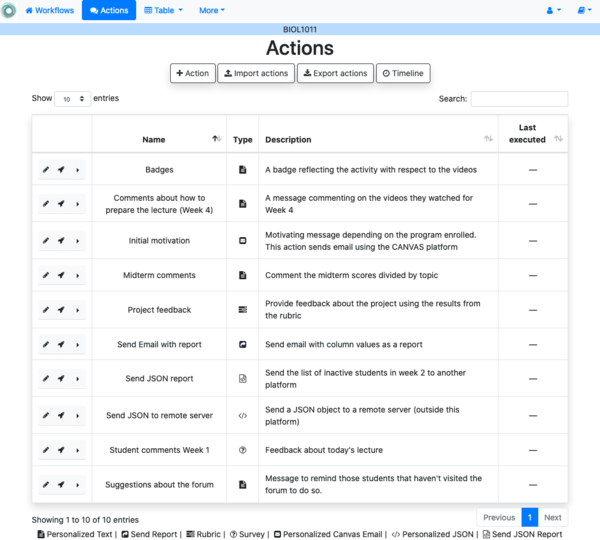

Les ressources créées peuvent être des pages HTML, des messages, des visualisations. Ces actions peuvent aussi être des sondages envoyés à des moments précis de la formation et permettant de récolter de nouvelles données qui viendront alimenter le système.

Les ressources envoyées peuvent avoir plusieurs utilités. Elles peuvent par exemple être un résumé de ce qui a été fait par l’étudiant durant un certain temps, fournir un encouragement lorsque l’étudiant commence à décrocher, apporter de nouvelles ressources si l’étudiant est en difficulté ou encore apporter une correction à un devoir. La figure 2 donne un exemple des actions élaborées par un enseignant.

Bilan

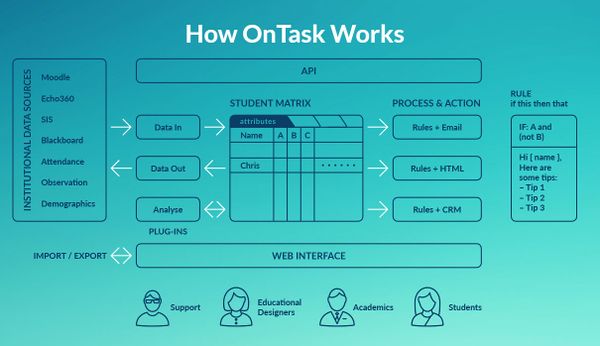

Finalement, OnTask est un outil qui analyse différents types de traces allant jusqu’à l’importation de données grâce à un API (application programming interface) depuis différentes plateformes. Il les modélise à un niveau comportemental permettant de comprendre les comportements et les profils des étudiants. Il utilise pour cela une méthode algorithmique et une méthode statistique qui serviront à l’application de règles établies par l’enseignant. Il permet aussi la visualisation de données grâce à des tableaux ou des dashboards. Le schéma ci-dessous permet de résumer le fonctionnement de cette application.

Analyse critique

Le learning analytic permet de récolter des données qui permettent d’avoir des informations sur les habitudes d’apprentissage, amélioration des performances, risques d’échec. Elles permettent aussi de prédire les besoins et anticiper les abandons des étudiants. Dans les contextes des hautes études avec de larges classes, les étudiants possèdent une diminution d'opportunités d’interagir avec le corps enseignant. De plus, ils doivent faire face à un apprentissage auto-régulé (Self Regulated Learning ou SRL) qui correspond à un contrôle de leurs pensées, de leurs émotions et de leurs actions pour atteindre les objectifs d’apprentissage. Ce processus, par étape et itératif, n’est souvent que trop peu développé chez les étudiants qui arrivent à l’université (Lim et al., 2021). Les feedbacks ont été identifiés comme l’influence la plus importante dans l’accomplissement académique des étudiants (Hattie, 2008, cité dans Pardo, Jovanović, Dawson, Gašević et Mirriahi, 2018). Des feedbacks de qualité permettent aux étudiants d’améliorer leur travail et d’augmenter leur engagement (Pardo, Jovanović, Dawson, Gašević et Mirriahi, 2018). Les feedbacks au bon moment et personnalisés permettent aussi le soutien du SRL (Lim et al., 2021). Cependant, il est constaté que plus il y a d’inscriptions au cours, moins les enseignants ont du temps pour faire de bon feedback personnalisé.

L’outil Ontask apparaît donc comme une solution idéale pour résoudre ce problème et semble n’avoir que des avantages aussi bien pour l’enseignant que pour les étudiants mais quelles sont les limites possibles de cet outil ? Dans la suite de cet article nous nous demanderons comment les étudiants perçoivent les feedbacks personnalisés, nous chercherons à savoir si l’outil proposé permet de pallier un manque de compétences dans l’analyse des learnings analytics ou si il ajoute des difficultés techniques et nous évoquerons l’aspect éthique de l’utilisation d’un tel outil.

Opinion des étudiants

Dans le texte de (Yilmaz et Yilmaz, 2020), les étudiants trouvent une satisfaction et des bénéfices dans les feedbacks personnalisés basés sur les learning analytics : amélioration du sens de la responsabilité, contrôle sur leur apprentissage, rythme d’apprentissage régulier, amélioration de la motivation et des propres méthodes d’apprentissage. De plus, cela permet aux enseignants une identification des déficiences, une régulation de leurs comportements d’apprentissage, une auto-évaluation, une amélioration des performances académiques.

Il est observé que les feedbacks personnalisés permettent un meilleur engagement dans leur apprentissage, car les étudiants sont conscients de la situation de learning analytics. Par exemple, une analyse a relevé une hausse de login et de vidéo regardée. Cet aspect permet un guidage, notamment pour les étudiants avec des compétences en SRL faibles. Pour accompagner davantage ces étudiants, il est aussi possible d’allier les feedbacks avec une présence active sur les forums. L’étude de Yilmaz, F. G. K., & Yilmaz, R. (2020) utilise de manière active les forums afin de développer la perception de la présence sociale auprès des étudiants. Dans le texte de Lim, L. A., Gasevic, D., Matcha, W., Ahmad Uzir, N. A. et Dawson, S. (2021), les étudiants perçoivent plus de contrôle sur la procrastination, une aide à la mise en place d’objectifs et un impact positif sur la motivation. De ce point de vue, OnTask ne semble pas présenter de limites majeures mais plutôt des avantages supplémentaires.

Compétences de l’enseignant

Les données sont récoltées à partir des interactions des étudiants avec le LMS. Dans un premier temps, les chercheurs donnent des recommandations (design et utilisation des LA) aux enseignants pour qu’ils puissent écrire des feedbacks (FB). Les feedbacks sont de type descriptif comme “Vous n’avez jamais regardé les vidéos du cours de la semaine. Vous devez regarder la vidéo pour pouvoir accomplir la tâche.” Il est recommandé d’accompagner les feedbacks généraux de feedbacks dits “métacognitifs” qui permettent aux étudiants de se questionner sur leur apprentissage et d’avoir plus de contrôle dans celui-ci (Yilmaz et Yilmaz, 2020). Les enseignants doivent être capables d' interpréter le LA pour écrire leur FB, afin de rédiger des FB permettant la progression de l’étudiant. De ce point de vue, OnTask facilite le passage des learning analytics aux feedbacks. En effet, Ontask a pour but d’accompagner les enseignants par la simplification de la lecture des données recueillies. Le logiciel nettoie et trie les données pertinentes qui présentent sous la forme de dashboard ou de tableau. Les enseignants s’en inspirent afin de déterminer leurs règles pour les feedbacks. Cependant, l’utilisation de cet outil les amène à apprendre un nouveau langage qui peut être une charge en plus dans leur temps de travail.

Deux aspects concernant les enseignants n’ont pas pu être étudiés et mériteraient des recherches supplémentaires : L’utilisation d’un logiciel de ce type demande un investissement de temps supplémentaire de l’enseignant par rapport à l’envoi de feedback généraux à tous les étudiants. Il conviendrait de tester la propension des enseignants à prendre ce temps si ils ont connaissance des bénéfices que cela pourraient apporter à leurs étudiants. Les enseignants habitués à leurs interfaces peuvent aussi se retrouver perdus sur ce nouveau logiciel et il convient de se demander s'il permet une bonne visualisation des données recueillies. Un premier élément de réponse vient du fait que cet outil propose un tableau récapitulatif des attributs par étudiant (le SDT) mais aussi des dashboards. Il pourrait être intéressant de tester si ces modes de visualisation conviennent aux enseignants.

Ethique et protection des données

En ce qui concerne l’utilisation éthique des learning analytics, la récolte de données peut produire un sentiment de surveillance constante et une atteinte à l'espace privé. Une relation de confiance doit être établie afin d’utiliser ces données. Il est donc important d’informer les étudiants que leurs données sont collectées, comment elles sont utilisées, qui a accès à ces données, et comment elles sont protégées (Yilmaz et Yilmaz, 2020).

Ressources

- Lim, L. A., Gasevic, D., Matcha, W., Ahmad Uzir, N. A. et Dawson, S. (2021). Impact of learning analytics feedback on self-regulated learning: Triangulating behavioural logs with students’ recall. Dans LAK21: 11th International Learning Analytics and Knowledge Conference (pp. 364-374).

- Pardo, A., Bartimote, K., Shum, S. B., Dawson, S., Gao, J., Gašević, D. et Vigentini, L. (2018). OnTask: Delivering data-informed, personalized learning support actions. Journal of Learning Analytics, 5(3), 235-249.

- Pardo, A., Jovanović, J., Dawson, S., Gašević, D. et Mirriahi, N. (2018). Using Learning Analytics to Scale the Provision of Personalised Feedback. British Journal of Educational Technology. doi:10.1111/bjet.12592

- Yilmaz, F. G. K. et Yilmaz, R. (2020). Student opinions about personalized recommendation and feedback based on learning analytics. Technology, Knowledge and Learning, 25(4), 753-768.